|

|

inviato il 08 Agosto 2023 ore 12:50

Intanto qui un excursus accademico sul DL applicato al denoising delle immagini:

arxiv.org/pdf/1912.13171.pdf

So già che interpreterai nella maniera sbagliata le immagini alle pagine 22 e 23: i quadratini rossi NON corrispondono ai pattern a cui mi riferisco, sono solo riquadri esemplificativi dei risultati.

Te l'ho detto, non è semplice per niente, è matematica alla fine, non un copia incolla di occhi e mani: quello lo fa MidJourney (e comunque SEMPRE tramite la matematica), ma quello si che inventa! E' il suo lavoro! |

user236140

|

inviato il 08 Agosto 2023 ore 13:40

Te lo dice pure Canon come usa la deep learning

"using millions of reference images to create a data library, which in turn is used to improve focusing performance for certain subjects"

e questi milioni di immagini sono state "grattate", come dimostra ad es. la causa in corso da parte di Getty Images

E anche se vincesse la causa, ormai i dati sono stati grattati, amen |

user236140

|

inviato il 08 Agosto 2023 ore 13:47

davidemonteleone.com/journal/2019/11/6/photography-and-machine-learnin

da cui estraggo, fra le altre cose:

"If this is true for the 4.7 trillion (Marr, 2017) images archived in 2017 alone, then it is undoubtedly even truer for digital images that are not produced with the aim of a playful, human consultation. These are the billions of 'operative images' (Farocki, 2004, p.660)—the digital images produced by the myriad sensors that surround our lives. These images not only lack the materiality that photography once possessed, but they are also images that are 'invisible' to human perception."

P.S. io faccio musica al PC e so bene cosa sono i sample e i MIDI

sono musica suonata da altri, quelli bravi

io mi limito a usarli come dei mattoncini per creare musiche a volte carine, ma so di non essere un musicista, né un compositore

si può quindi dire che i fotografi che usano IA, usano dei mattoncini di roba altrui e li assemblano (più o meno bene) per i propri scopi, amen

|

|

|

inviato il 08 Agosto 2023 ore 13:50

E' assurdo pensare che l'interpolazione di un programma di denoising si basi su un 'copia e incolla' di immagini simili.

assurdo semplicemente perché occorrerebbe un database di proporzioni planetarie ed una rete in grado di soddisfarne il traffico.

L'interpolazione è ben altro, si tratta della 'decisione' di creare una figura finita partendo da una serie di pixel da parte di un SW studiato allo scopo.

e personalmente sono dell'opinione che NULLA venga inventato da questi SW, semplicemente viene letto, interpretato e 'SPIEGATO' (mi si consenta il termine letterario) cioè restituito con una migliore leggibilità.

Ad esempio, a mio parere è ammirevole quello che -a volte- riesce a fare Topaz Gigapixel AI, che oltre ad eseguire un ragionevole denoising riesce a rendere leggibili vecchie immagini digitali molto pixelate e senza aggiungere alcun dettaglio, semplicemente rendendo più leggibili le 'scalette' dei dettagli pixelati. E' poi vero che questo SW lavora bene su immagini di pochi mpixel (l'ottimo è non più di 12) però è ben efficace -e senza inventare nulla- |

user236140

|

inviato il 08 Agosto 2023 ore 13:53

ecco un articolo interessante

cgarbin.github.io/deep-learning-for-image-processing-overview/

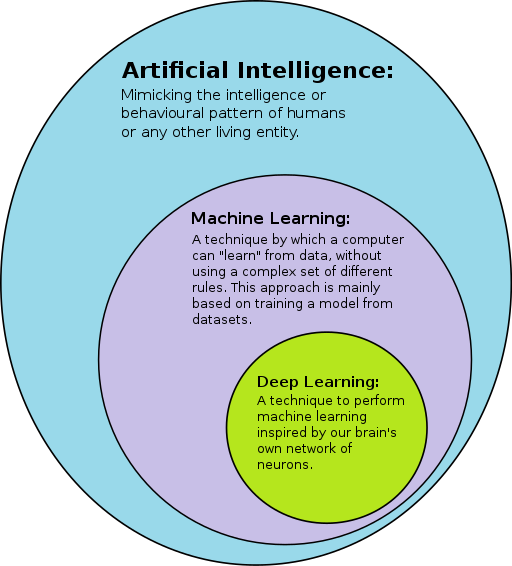

il primo disegno illustra i concetti togliendo tutta l'aura di intelligenza mistica che l'acronimo IA diffonde

La realtà dice che buona parte di quel che contiene è attualmente nel regno dei sogni

la macchina non è intelligente affatto: non crea dal nulla e non inventa nulla

usa solo una massa enorme di mattoncini per correggere quel che trova di errato in un'immagine tipo l'occhio sgranato

Ho provato topazzo denoioso e ho visto che fa proprio quello: a seconda del setting (conservativo, medio, esagerato) incolla un occhio (grossolanamente dei 3 livelli prima indicati) buono su uno sgranato o penne buone su penne sgranate, amen |

|

|

inviato il 08 Agosto 2023 ore 14:46

“ Ho provato topazzo denoioso... „

nella mia galleria... tutte le diapositive digitalizzate sono state fatte passare attraverso Topaz, con risultati più o meno validi.

Di dettagli incollati/copiati non ne percepisco. La mia opinione è che il programma legga i granuli d'argento (uno per uno) e vada ad interpolarli con quelli adiacenti in sostanza: spalmando/amalgamando il colore/tono.

Come ho scritto in precedenza: anche Kodak, negli anni '80 (circa), sperimentò un SW per amalgamare la grana delle pellicole formato disk -con risultati apprezzabili- sebbene, ovviamente, non così bene come oggi riesce a fare Topaz, o meglio, DxO prime. Quel che è sicuro è che allora di 'AI' non ne parlava nemmeno la fantascienza eppure, negli anni del trionfo dell'analogico, già ci provavano a farlo.

Comunque: menomale che l'hanno inventato... |

|

|

inviato il 08 Agosto 2023 ore 15:47

Che cosa c'entra questa roba con il DeNoise ?

Mi pare un po' semplicistico considerare il deep learning e le reti neurali come un semplice copia/incolla fosse così non servirebbero le risorse di calcolo che invece sono necessarie

Topaz Denoise genera un mucchio di artefatti (che non hanno comunque nulla a che fare con copia/incolla) ma prova Dxo DeepPrime è un algoritmo integrato di demosacizzazione/denoise che può essere usato di default con qualunque immagine a qualunque iso senza generare artefatti di sorta. |

user236140

|

inviato il 08 Agosto 2023 ore 15:53

Ma perché non leggete cosa dice Adobe stessa?

L'algoritmo preleva pezzi di foto dal database e le incolla al punto giusto in modo che non sembri incollato...

In realtà, gli occhi assurdi del gatto di notte sono la prova provata che è un copia-incolla

Di intelligente non c'è niente, roba che si potrebbe fare con fotoscioppe, come incollare cieli farlocchi, cosa che si fa da eoni

A parte l'aumento delle vendite dei programmi: questo sì è intelligente |

|

|

inviato il 08 Agosto 2023 ore 16:08

quello fa il traduttore di professione ma non capisce cosa scrivono, è il top

E' convinto che incollano pezzi? Ho ha cambiato? |

|

|

inviato il 08 Agosto 2023 ore 16:14

TheBlackbird, Claudio Porcellana

In pratica entrambe le cose sono vere entro i limiti del ciò che si vuole ottenere.

Nel Deep Learning per la denoising, è necessario avere accesso a una base di dati contenente coppie di dati rumorosi e dati puliti corrispondenti, quindi in fase di addestramento è necessario anzi direi indispensabile avere un numero spropositato di queste coppie, qualitativamente buone ( Claudio Porcellana e qui ovviamente nessuno può mettere la mano sul fuoco su come e dove sia stato fatto lo scraping dei dati, ma calcola che hai vissuto per quasi 20 anni senza regole di privacy, copyright etc.... quindi adesso sicuramente è controllata la questione ), al fine di coprire il maggior numero di casistiche possibili, verranno creati N modelli che poi saranno ridotti per numero in base alle somiglianze, quindi in ultimo verrà confezionata la base dati, in questa base di dati ci sono sia pattern come dice TheBlackbird ossia linee, sfumature, texture o qualsiasi cosa che si ripete; che strutture visive ossia quegli elementi presenti in una immagine che la compongono come edifici, alberi, veicoli, persone e posizione di esse.

Come funziona in soldoni?

Nel caso di denoise di un'immagine con un uccellino (vedi quella di Juza), il modello di Deep Learning cercherà pattern come le piume dell'uccello, la struttura del becco, gli occhi e altri dettagli anatomici. I pattern potrebbero includere anche le sfumature di colore delle piume o delle ali, così come le linee e le curve che compongono il corpo dell'uccellino.

Mentre per le strutture visive in questo caso includerebbero la posizione dell'uccellino all'interno dell'immagine, il suo orientamento, la direzione in cui guarda e la sua relazione con lo sfondo circostante. Mantenere queste strutture visive è importante per garantire che l'uccellino appaia in modo realistico e coerente nell'immagine denoised.

Se stai utilizzando un dataset locale per addestrare un modello di Deep Learning per il denoise delle immagini e questo dataset non contiene esempi del tipo specifico di uccellino presente nell'immagine, potrebbero verificarsi alcune situazioni,

come risultati meno accurati, caratteristiche mancanti, interpolazione ossia artefatti perchè è andato a pescare da oggetti( uccellini simili ).

Detto questo si può lavorare in locale senza problemi, nei limiti di quello che ho detto sopra, un dataset in generale deve avere una buona qualità dei dati, una varietà discreta, ma nel caso di complessità del problema servono grandi dimensioni, anche se qui potrebbe esserci il rischio di overfitting, ossia non generalizza ma impara a memoria

e poi richiede risorse computazionali pesanti. Quindi se è una dataset specializzato molto bene allora si come dice TheBlackbird si può lavorare anche con piccole dimensioni, per situazioni mirate.

Ciao a tutti, spero di aver placato gli animi!!!

PS: nel caso di midjourney... stiamo confendendo i pani con i pesci.... in quel caso si parla di NLP, RNN, GAN... ma li lascio la palla a TheBlackbird, se ha voglia di spendere due righe

|

|

|

inviato il 08 Agosto 2023 ore 16:31

@Gerryr76

Adobe con tutte quelle foto stock che ha hai voglia ad addestrare modelli.

Shutterstock vende direttamente i dataset |

|

|

inviato il 08 Agosto 2023 ore 16:43

Murphy rispondevo a Claudio Porcellana in merito al copyright dei dataset che sono stati utilizzati, nel senso che teoricamente le aziende usano dataset pubblici o li acquistano, poi appunto nessuno può metterci la mano sul fuoco, in passato abbiamo vissuto in un farwest, per i volti delle persone è stato fatto di tutto e di più illegalmente... vedi il caso Megaface.... di certo meglio non pensarci.... io ogni volta che penso al famoso buchino frontale della camera degli smartphone e di tutti quegli anni senza regole..... o cmq nebulose! Spero di essere uscito almeno fotogenico! ahahah |

|

|

inviato il 08 Agosto 2023 ore 16:47

“ Te lo dice pure Canon come usa la deep learning „

Google non trova il pezzo esatto che hai citato, devo dedurne che non esiste? Mi fornisci il link dove l'hai trovato?

Comunque a voler essere benevoli, ciò che descrive il pezzo citato riguarda il come Canon usa il DL per riconoscere i soggetti nell'AF, e quindi è tutta un'altra storia: si tratta di RICONOSCIMENTO di soggetti in un'immagine ed è fuori tema dato che l'oggetto è il denoise mediante DL.“ Che cosa c'entra questa roba con il DeNoise ? „ Direi nulla, restringiamo il campo a quello.

“ "If this is true for the 4.7 trillion (Marr, 2017) images archived in 2017 alone, then it is undoubtedly even truer for digital images that are not produced with the aim of a playful, human consultation. These are the billions of 'operative images' (Farocki, 2004, p.660)—the digital images produced by the myriad sensors that surround our lives. These images not only lack the materiality that photography once possessed, but they are also images that are 'invisible' to human perception." „ E quindi? Se questi triliardi di immagini, che formano dei database su cui addestrare reti di DL, sono ottenute nel rispetto della legalità, perché non potrebbero essere usate per addestrare reti neurali a scopo di DL?

Se poi vuoi credere che è tutto sporco, fà pure, non ti strapperò dal tuo convincimento pessimistico.

Ma sappi che per 1 singolo utilizzatore "illegale" di immagini a scopo di training di DL, ce ne sono una miriade puliti... il furto di immagini è una cosa ben diffusa a livello "amatoriale", ma non così tanto in ambito industriale come credi.

C'è solo Getty Vs Stable Diffusion, come esempio di supposto furto?

Supposto, perché mi pare di capire che la causa sia in corso, sei già sicuro che Getty ha ragione?

“ ecco un articolo interessante

cgarbin.github.io/deep-learning-for-image-processing-overview/ „ Anche qui si tratta di riconoscimento immagini, NON di denoise... detto questo, la domanda fondamentale: mi spieghi come può un sistema di tutor autovelox autostradale quale Vergilius riconoscere una targa che passa, se non apprendendo sulla base di milioni di immagini di targhe riprese in precedenza?

“ l'aura di intelligenza mistica che l'acronimo IA diffonde „ Mi sa che l'ha diffusa solo su di te Claudio. Io so bene che strumento è l'IA, cosa sia il DL e a cosa serva, come ottenga i suoi risultati e non ho bisogno di considerare niente di tutto questo "mistico", al più è utile ai miei scopi e confacente con i miei limiti "morali" ed estetici, sia in generale che in fotografia.

“ Ma perché non leggete cosa dice Adobe stessa?

L'algoritmo preleva pezzi di foto dal database e le incolla al punto giusto in modo che non sembri incollato... „ Qui stai parlando dell'allargamento e autocompletamento dell'immagine, NON del denoise, quindi anche in questo caso non riguarda l'oggetto del topic... e comunque anche stavolta, ripeto la domanda fondamentale: se tu gli chiedi di aggiungere un asino sfocato sullo sfondo, mi rispieghi come potrebbe farlo se non prelevandolo da un'immagine di un asino sfocato che Adobe possiede fra le immagini regolarmente acquisite (o secondo te irregolarmente) nella sua base dati?

E infine veniamo all'unica risposta probante per il denoise:

“ Adobe stessa rivela che:

These are small crops from detailed regions of real photos. They contain material from everyday life. Bricks and branches, trees and twigs, cloth and fabrics, and so on. „

E' quello che ho detto finora! Quelli sono PATTERN, i piccoli pezzetti che ho citato io dall'inizio, ma essi vengono usati per INTERPOLARE.

Lo hai citato tu stesso, ecco qui:“ With enough examples covering all kinds of subject matter, the model eventually LEARNS to denoise real photos in a natural yet detailed manner. „ Il denoise NON CE LI SCHIAFFA DIRETTAMENTE: li USA per interpolare i pixel della TUA foto, con l'obiettivo di NON stravolgerli.

Se poi gli chiedi troppo, è chiaro che si basa TROPPO su quei pattern e crea cose che non ci sono.

Ma se lo sai usare, o se l'algoritmo con le opzioni di default è tarato BENE (come il Deep Prime di DxO) ciò non avviene.

Ho fatto un denoise a 40mila ISO molto migliore e più veritiero di quel gatto di esempio di Adobe.

Eccolo, buon divertimento:

theblackbird.prodibi.com/a/gygmo946lomkx0r/i/wy0yl76242r92dz?s=h6pDi5C

Il gatto, appunto, è a 30000 ISO, e il tizio che ha compilato l'articolo Adobe ha esagerato col noise model, quindi il gatto appare artificioso.

Che mi vuoi dimostrare?

Che quindi i denoise Ai sono per forza forieri di risultati finti?

Anche no.

Dipende come li usi e in che contesto li usi.

Se spingi il livello di denoise a palla su 30mila ISO in bassa luce, per forza esce la schifezza.

Ma ti metto subito nella situazione opposta, per darti la contro-dimostrazione: fai una foto a 30mila ISO a quel gatto con scarsa luce, poi con un denoise classico (di quelli che tu consideri "moralmente retti", o "non scorretti", secondo il tuo giudizio soggettivo, fai denoise TENTANDO di ottenere qualcosa anche solo minimamente stampabile in formato A3 (non salgo oltre per decenza).

L'unica cosa che otterrai è un acquerello, un quadro impressionista che sarà perfino più brutto del pelo del gatto che in quell'esempio hai considerato artificioso. Quindi cos'è meglio? Interpolare nel tentativo di restaurare il più possibile, preservando la naturalezza della foto ( denoise real photos in a natural yet detailed manner ), o piallarla?

Io la mia risposta ce l'ho, e come me il 99% dei conoscitori ed utilizzatori consapevoli di questi strumenti.

“ Se non capite è perché non volete, amen „ E due. Comincio a spazientirmi degli insultarelli generici. |

|

|

inviato il 08 Agosto 2023 ore 17:01

@Gerryr76

non era diretta a te lo so, immagina tutti quelli che si fanno i selfie con le varie app che ti invecchiano (faceapp e simili) quanti dati hanno fornito.

@TheBlackbird

almeno non ti ha bloccato |

|

Metti la tua pubblicità su JuzaPhoto (info) |

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.