|

|

inviato il 22 Ottobre 2018 ore 0:03

Il problema è che hai correlato male lo shot noise e il read noise. Il sensore ha un funzionamento ibrido (analogico ed elettrico). Il rapporto s/n migliora all' aumentare dei fotoni per entrambi i tipi di rumore. Esiste anche il SEGNALE elettrico prima di essere convertito, mica solo il rumore. Mentre le zone meno illuminate soffrono principalmente di read noise, quelle più illuminate soffrono principalmente di shot noise. L' andamento è quello. Luci e ombre.

PRINCIPALMENTE per il digitale il rumore è dovuto all' elettronica.

|

|

|

inviato il 22 Ottobre 2018 ore 0:26

In sintesi: un sensore e l'elettronica associata originano una serie di rumori diversi che assumeremo casuali (se no non è più rumore, è cattiva elettronica). Tutti questi rumori sono nocivi al SNR finale, cioè non portano segnale, portano solo disturbo casuale. L'unica fonte di segnale è data dai fotoni. Appena ti metti a convertire fotoni in elettroni-lacune, il segnale dei fotoni è accompagnato da rumore statistico. Il rumore proveniente dalla registrazione della luce non è veramente casuale come i rumori propri del sensore. Solo qui entra in gioco la quantistica: se raccogliamo i fotoni il loro segnale sarà misto a rumore e per i fotoni che sono bosoni questo rumore sarà pari a sqrt(n) dove n è la media dei fotoni raccolti.

La quantistica ci ha dato questa informazione: il segnale totale raccolto (compreso il rumore) è pari a n, quindi S=segnale=n. Il rumore R abbiamo visto che è pari a sqrt(n). I nostri occhi apprezzano il rapporto segnale-su-rumore SNR non il rumore in sé. Possiamo calcolare SNR? Certamente: sarà S/R che è = n/sqrt(n)=sqrt(n). Non è finita, dobbiamo includere qualsiasi altro rumore che non c'entra con la luce, ma proviene dal sensore. Si fa con RSS (vedi sopra) dei vari rumori del sensore con in più il rumore apportato dalla luce (shot noise).

Ricalcoliamo SNR: nella stragrande maggioranza dei casi rimane SNR=sqrt(n) perché lo shot noise è talmente preponderante che il rumore proprio del sensore è trascurabile (bassa, media, buona luce). In pessima luce il rumore del sensore si avvicina allo shot noise e allora sono 'azzi. Si vede in astro, nei notturni, quando per necessità si scatta a 25,600 ISO. Quindi teorema di Pitagora e un attimo di pazienza e tutto si tiene.

Ma l'unica cosa da capire è che il rumore lo porta la luce stessa, il sensore poareto si limita a registrarlo e il rumore che fa il sensore è QUASI sempre innocente. "Rumore intrinseco alla luce" è un'abbreviazione di tutto questo, segnale e rumore si riferiscono a MISURE, non c'entra una 'ega con i fotoni non MISURATI. |

|

|

inviato il 22 Ottobre 2018 ore 0:45

Bubu grazie dei chiarimenti. Ancora mi rimane un dubbio però, ed è sull'azione del LENR, cioè sul dark frame che la macchina scatta e poi sottrae alla foto. Questo procedimento può essere valido per sottrarre il rumore a condizione che:

- il rumore si presenti come pattern per cui, ripetendo lo scatto in diversi momenti gli errori di lettura sono sempre distribuiti in quelle zone del sensore

- il rumore, pur avendo distribuzione casuale come tu dici abbia il thermal noise, nel caso lo scatto "dark" venga ripetuto immediatamente dopo il light frame veda il rumore distribuirsi esattamente negli stessi punti del sensore.

Se così non fosse, cioè se il rumore dello scatto dark frame fosse distribuito sul sensore in modo casuale e dunque diverso rispetto a quello parimenti casuale generatosi durante la lunga esposizione, non avrebbe alcun senso sottrarlo ad essa.

Come pure mi pongo questo dubbio: non avrebbe senso raddoppiare l'esposizione esattamente dello stesso tempo del light frame per scattare un dark frame se non per eliminare il thermal noise o comunque quel tipo di rumore che, chiamiamolo come vogliamo, evidentemente aumenta all'aumentare dell'esposizione, perché altrimenti basterebbe fare quello che si chiama se non erro flat frame o bias frame, cioè uno scatto con tappo ed otturatore chiuso brevissimo e sottrarre quello senza perdere tempo.

In altre parole mi chiedo che senso ha una funzione LENR se non per sottrarre un rumore non casuale e legato al prolungamento dell'esposizione stessa?

Ma mi chiedo anche questo: io gli effetti benefici di questa LENR non li vedo mica tanto, che sia appunto perché sto thermal noise è di fatto casuale e non si ripete uguale nemmeno in due scatti immediatamente successivi? e cosa la tengono a fare allora questa funzione?

|

|

|

inviato il 22 Ottobre 2018 ore 5:52

Uno dei miei interessi è Filosofia (anche Storia) della Scienza. Una paio di osservazioni.

Nelle Trasformate di Fourier è implicito il principio di indeterminazione. Stando ai domini tempo/frequenza significa: se vuoi determinare una frequenza con la massima precisione, devi registrare il fenomeno nel tempo il più a lungo possibile.

Heisenberg non è assolutamente arrivato al principio di indeterminazione partendo dalla FT. Si riferiva a particelle dotate di massa m e diceva: o determino il momento mv di una particella con grande precisione o la sua posizione.

Ora: il fotone non ha massa, come fai ad osservare mv? Di un fotone si può però CERCARE di misurare l'energia E=hf.

Con questo approccio si è visto che il principio di indeterminazione regge anche nel caso dei fotone. f determina il colore, ne parlo perché il colore è ovviamente centrale nella percezione di un fotografo,

Adesso vediamo la potenza predittiva della quantistica: se il principio di indeterminazione è verificato, allora la luce è soggetta a diffrazione. La diffrazione era nota da tempi lontani, ma la quantistica la mette in conto partendo dal principio di indeterminazione. In soldoni: caro fotografo chiudi pure il diaframma quanto vuoi, ti castigo allargando il disco di Airy, lavora a tutta apertura e allora ti riduco il disco di Airy. Al disco di Airy si arriva presupponendo la natura ondulatoria della luce, è una derivazione difficile perfettamente legittima quando la luce si comporta come un'onda.

Quindi: rifrazione e diffrazione spiegabili con la natura ondulatoria della luce (ossia il 90% dell'ottica fotografia di intersse ai fotografi). Se invece si parla dell'interazione fotone-Silicio la visione ondulatoria CLASSICA non la spiega, bisogna ricorrere ai quanti come fece Einstein nel 1905 per l'effetto fotoelettrico. Qual'è la differenza? La teoria ondulatoria era supportata fra le altre cose dalla diffrazione, invece il principio di indeterminazione ne presuppone semplicemente l'esistenza, cosa confermata sperimentalmente. Qui sul forum ci sono fior di ingegneri con una mediocre conoscenza della quantistica che salteranno sulla sedia, scommetto che salterà fuori ancora qualche super×la. Calma e gesso: questi ingegneri hanno solo sentito parlare della quantistica, magari si sono laureati tanti anni fa (come me (1972), ma io mi interesso di filosofia della scienza ADESSO).

Ultima notazione: Angela Merkel è una fisica che ha proseguito con un PhD in chimica teorica (cioè quantistica), le capita di incontrarsi col nostro premier Conte che si è letteralmente comprato la cattedra universitria e si tiene in tasca il santino di Padre Pio...

|

|

|

inviato il 22 Ottobre 2018 ore 10:23

“ Ultima notazione: Angela Merkel è una fisica che ha proseguito con un PhD in chimica teorica (cioè quantistica), le capita di incontrarsi col nostro premier Conte che si è letteralmente comprato la cattedra universitria e si tiene in tasca il santino di Padre Pio... „

Val, mi hai fatto cadere dalla sedia dal ridere  |

|

|

inviato il 22 Ottobre 2018 ore 10:35

Altre domande che talvolta mi pongo:

-ma tutte queste long exposures che faccio, che durano anche 3 minuti, anche nel caldo delle notti estive, in cui sul sensore si manifestano tutti questi hotpixel, dai e dai non danneggiano il sensore?

- questi hotpixel che si manifestano nelle lunghe esposizioni non compaiono anche nei filmati che, magari, durano anche più di alcuni minuti? (sono uno che non ha mai usato la macchina fotografica per fare filmati, anzi, mi spiace anche se penso che forse un 20% di quello che ho speso per comprarla se ne sia andato per la sezione "movie" di cui non me ne può fregar di meno, ma tant'è, così van le cose) |

|

|

inviato il 22 Ottobre 2018 ore 11:28

Sì, il rischio di danneggiare il sensore c' è, esattamente come per i controluce al sole. Dovremmo smettere? Direi di no. Magari non fare lunghe esposizioni una dietro l' altra e dai il tempo al sensore di raffreddarsi. Le prove di esposizione si fanno a tempi corti e iso altissimi per poi ricalcolare la coppia, per fare prima, per non surriscaldare il sensore e non dover aspettare troppo prima dello scatto utile.

Gli hot pixel si manifestano a causa della corrente prodotta dai fotodiodi (motivo proncipale). I video hanno un tempo "morto" tra un frame e l' altro in cui i fotodiodi non producono segnale, a 25fps esponi al massimo a 1/30. Non so se ci siano altri motivi, ma qui c' è qualche videomaker che può approfondire. |

|

|

inviato il 22 Ottobre 2018 ore 13:57

“ se così non fosse, cioè se il rumore dello scatto dark frame fosse distribuito sul sensore in modo casuale e dunque diverso rispetto a quello parimenti casuale generatosi durante la lunga esposizione, non avrebbe alcun senso sottrarlo ad essa. „

Giustissimo, infatti i dark non li fai per eliminare tutto il rumore termico (cosa impossibile dato che non c'è modo di distinguerlo dal segnale normale dell' immagine) ma per togliere un eventuale componente non casuale del rumore termico (tipo l'amp glow di cui ho parlato prima) e gli hot pixel.

In realtà sarebbe più corretto parlare di "segnale termico" in questo caso più che di rumore.

Se io ho un' immagine x con 30s di esposizione e una media di 1000 ADU per pixel e scatto un dark posso vedere che in media in una zona dell' immagine avrò (per esempio, cifre sparate a caso) 50 ADU di segnale termico, mentre vicino all' amplificatore magari il segnale termico sarà di 75 ADU.

Questo può essere visibile nell' immagine dato che la zona vicina all' amplificatore avrà un alone che nel resto della foto non c'è.

Con un dark puoi eliminare quella componente di segnale costante, però non puoi eliminare il rumore associato ad essa (che è, come nel caso dei light, rumore casuale tipo shot noise!) che comprometterà comunque un po' la qualità d'immagine finale.

Nel mio esempio se hai 1000 ADU medie per pixel lo shot noise sarà circa SQRT(1000)=33, a cui devi aggiungere il rumore termico associato al segnale termico medio che è SQRT(50)=7.07 circa, mentre vicino all' amplificatore avrai SQRT(70)=8.37.

Tu puoi eliminare il SEGNALE TERMICO medio con i dark rendendo l'immagine più uniforme, non il rumore associato a quel segnale.

Per farti un' analogia, in fotografia astronomica se hai dell' inquinamento luminoso lo puoi facilmente eliminare sapendo che il fondo cielo deve avere un certo valore, quello che però non puoi eliminare è lo shot noise associato all' inquinamento ed è QUELLO che ti devasta le foto. Se l'inquinamento fosse un valore fisso (che ne so, 500 ADU per pixel) basterebbe sottrarlo dal valore di ogni pixel per ottenere il segnale dell' oggetto che stai fotografando e non sarebbe un problema, invece quelle 500 ADU essendo segnale luminoso si portano con loro una componente di rumore, in questo caso SQRT(500)=22 circa che ti devasta la foto

“ Ma mi chiedo anche questo: io gli effetti benefici di questa LENR non li vedo mica tanto, che sia appunto perché sto thermal noise è di fatto casuale e non si ripete uguale nemmeno in due scatti immediatamente successivi? e cosa la tengono a fare allora questa funzione? „

Non sei l'unico che li vede poco

Ultimamente ci sono discussioni sul fatto se sui sensori moderni sia ancora sensato oppure no scattare i dark dato che comunque i dark, essendo in fondo delle normali immagini, si portano dietro una loro componente di read noise, quindi se un sensore è già uniforme di suo scattare i dark non solo non uniforma il rumore termico ma rischia addirittura di peggiorare la qualità! |

|

|

inviato il 22 Ottobre 2018 ore 18:41

Graie Bubu per le tue risposte con spiegazioni molto chiare e pertinenti |

|

|

inviato il 23 Ottobre 2018 ore 0:31

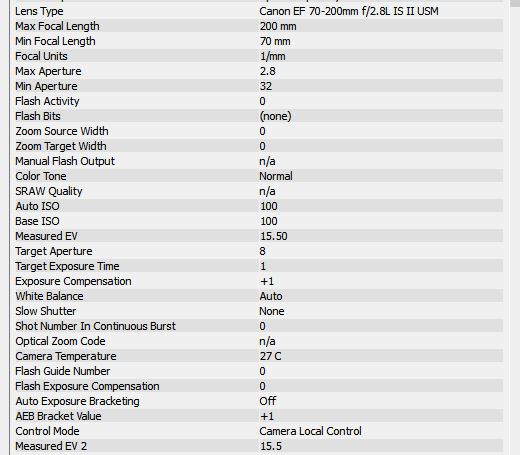

@Andrea la Canon 5DSR riporta nell'EXIF la temperatura della macchina:

Vai a controllare la temperatura della tua Canon e da manuale tenta di capire dove viene campionata. Sarebbe bello che fosse il sensore, potrebbe essere qualsiasi altra parte del corpo, solo il manuale te lo può chiarire. In questo caso la temperatura è 27 °C.

Attenzione che la temperatura termodinamica non si esprime in °C bensì in °K (Kelvin): K=C+273.15. Se il sensore a freddo è a 20 °C e dopo un certo uso è passato a 40 °C, si potrebbe pensare che la temperatura sia raddoppiata come da 40/20= 2. Invece il vero rapporto è dato da:

313.15/293.15=1.067

Il passo successivo è vedere la dipendenza fra i vari rumori generati dal sensore stesso e T (in °K).

K è la stessa unità di misura che si usa nella temperatura colore, in genere si assume per luce solare a mezzogiorno 5200 K. Se non fai astro, il rumore termico del sensore è relativamente insignificante. Anche se ho visto che continuano a esserci quelli che non lo capiscono, il rumore preponderante è il photonic shot noise. Più c'e luce, più shot noise c'è, ma ricordati che a te interessa SNR, non il rumore. Il SNR è pari al rumore, raccogli n fotoni e sarà SNR=sqrt(n). Ci si arriva per via quantistica, ma mi sembra che una radice quadrata sia alla portata di tutti!

Segui Bubu che a sua volta segue Clarkvision, buon riferimento, ma di una inutile verbosità (l'è un menaturön).

In rete c'è uno splendido "bigino" in italiano compilato da Alessio Beltrame (un ing. gestionale, gran fotografo di calcio minore). È un pdf gratis, al massimo trovi qualche typo qua e là, siamo a livello di eccellenza www.alessiobeltrame.com/ |

|

|

inviato il 23 Ottobre 2018 ore 4:34

“ Mi sono arreso a chi non capisce, non può o non vuole capire. Ma non è giusto nei confronti di chiunque ne ha voglia..

Posto questo link, semplice ed esaustivo. Magari è colpa mia se non mi esprimo bene.

I sensori, la loro densità, la loro dimensione, la gamma dinamica, la loro sensibilità, il ridimensionamento, la dimensione di stampa in relazione alla dimendione del sensore e alla risoluzione.

Spero che possa essere utile a qualcuno.

blog.francescophoto.it/2009/05/06/sfatiamo-i-miti-piu-pixel-piu-rumore „

Alessandro, ho iniziato a leggere l'articolo e mi sono fermato, chi lo ha scritto non dimostra una buona conoscenza dei sensori di immagine.

Parla di sensori di pari tecnologia stessa dimensione e risoluzioni differenti, tenta di sostenere che il rumore "a stampa" sia il medesimo (il rumore generale dell'immagine), nonostante la dimensione inferiore dei pixel di quello a risoluzione superiore. Date le premesse, con la tecnologia attuale, questo non é possibile.

Alcune argomentazioni sono giuste e sconosciute per alcuni, ma lo scrittore dimentica un limite fisico dei sensori: a pari dimensione del sensore, più i pixel sono piccoli minore é la superficie fotosensibile totale. Minore questa superficie, minore il quantitativo di fotoni raccolto, maggiore il rumore. Non si scappa.

I sensori retroilluminati aiutano a ridurre le dimensioni dei circuiti sui pixel, le microlenti aiutano a ridurre la perdita di superficie causata da questi circuiti e dai bordi dei pixel, ma ancora non si é in grado di sfruttare il 100% della superficie utile di un sensore, e più piccoli sono i pixel minore é il rapporto superficie fotosensibile/superficie geometrica di ogni pixel.

Conclusione, a pari tecnologia e formato, più megapixel corrisponde a più rumore. Di quanto? Sempre meno... Ma non lo si può negare.

Ho letto solo alcune pagine non tutte e 13... Se ho ripetuto cose giá dette mi scuso.

|

|

|

inviato il 23 Ottobre 2018 ore 7:16

@Leonardo non voglio togliere niente a francescophoto, sicuramente un blogger entusiasta, ma se parti dalle sue "interpretazioni" sei praticamente spacciato. Perché lui non ha idea delle basi teoriche che in forma semplificata ho esposto più sopra. Le cose le ha capite a esagerare al 60%: uno lo legge e magari capisce l'80% di quel 60% e siamo già al 48%. Resta fuori il 52% non capito nella catena, allora si riempiono i vuoti con "interpretazioni". Naturalmente una interpretazione o intuizione di Einstein non può avere lo stesso peso di uno che ad andare bene è un perito.

Personalmente se ho dubbi sul rumore, vado a rileggermi Fossum che ha introdotto i sensori CMOS. Constato che di dubbi ne ha anche lui, allora cerco altri fisici/ingegneri che hanno analizzato il problema da un altro angolo. Insomma, non si nasce imparati. Ho individuato parecchi "contromano-in-autostrada" sotto Juza, in genere meno hanno capito e più sono aggressivi e talvolta anche offensivi.

Il consiglio è: individuare i "contromano" e avvalersi delle cose che hanno capito e rifuggire dalle loro "interpretazioni".

Posto qui per ritardare l'inevitabile demenza senile (sono del '47). Dal punto di vista teorico ho imparato quasi niente in questi Juza Forum, invece dal punto di vista artistico mi aiuta molto, mi ricorda continuamente come sia un fotografo mediocre |

|

|

inviato il 23 Ottobre 2018 ore 9:34

“ ho iniziato a leggere l'articolo e mi sono fermato, chi lo ha scritto non dimostra una buona conoscenza dei sensori di immagine. „

Ma infatti! Non dimentichiamo che si tratta della stessa persona che ha inventato la perla secondo cui le moderne fotocamere non sarebbero davvero digitali perchè "[] ... un sensore digitale per definizione dovrebbe rispondere solo alle sollecitazioni derivate dalla luce incidente con solo due stati, on off, 0 1, bianco nero ...[] ", confondendo clamorosamente il significato di 'digitale' con quello di 'binario'!!

|

|

|

inviato il 23 Ottobre 2018 ore 11:10

@Leonardo Mengoli, giusta osservazione sulla superficie, ma sensori più densi hanno una maggiore efficienza per la lavorazione del silicio. La tecnologia ha diverse soluzioni ai problemi, come le microlenti.

Arriva più luce e il sensore cattura più fotoni non è così logico come pensi, si scappa invece. I sensori hanno tutti sensibilità diversa e non è correlata alla densità (in minima parte sì, molto minima). Se pensi all' efficienza dei sensori degli smartphone e a quella delle FF per mm quadrato, il divario è imbarazzante e i sensori degli smartphone hanno densità 10 volte maggiori.

Quelle conclusioni sui sensori riportate sul blog non sono farina del suo sacco, ma sono le conclusioni a cui sono arrivati gli ingegneri di DXO. Le avevo già lette e rilette tempo fa. Tutto fila. Basta confrontare 10000 fotocamere RIDIMENSIONANDO i file e scoprire che non c' è alcuna relazione tra s/n, gamma dinamica e densità dei sensori. Hanno prestazioni differenti indipendentemente dalla loro densità.

Se non si scappasse chi comprerebbe mai una fotocamera oggi se non può almeno uguagliare una FF da 6mpx di 15 anni fa?

|

|

|

inviato il 23 Ottobre 2018 ore 15:47

@Cosmosub, mi hai incuriosoto e ho letto l'articolo. Diciamo che si "salva" un minimo alla fine, quando conclude che “ Le fotocamere digitali quindi sono delle fotocamere che registrano un'immagine con un sensore analogico e poi la digitalizzano al loro interno. „ , l'errore che commette é nella definizione di "sensore digitale". La realtá che ci circonda é analogica (da un punto di vista macroscopico, non tiriamo in ballo la fisica quantistica), quindi qualsiasi sensore che interagisce con essa (mi riferisco a qualsiasi tipo di sensore) deve rilevare una fonte analogica, questo perché la fonte digitale in natura non esiste. Dov'é che un sensore prende l'attributo di digitale? Nel momento in cui converte questa lettura salvandola in digitale (sbaglio?), esattamente quello che fanno i sensori di immagine attuali. La sua argomentazione su quale sarebbe un vero sensore digitale é a mio parere fantasiosa e ingenua.

“ confondendo clamorosamente il significato di 'digitale' con quello di 'binario' „ sì commette anche questo errore

@Alessandro, “ sensori più densi hanno una maggiore efficienza per la lavorazione del silicio „ , se ti va' di condividere le tue informazioni a riguardo le leggo con interesse. In linea di principio mi sembra strano pensare che l' "efficienza per la lavorazione del silicio" possa risultare superiore lavorando su spazi inferiori (a pari capacitá tecnologiche ovviamente, che é quello di cui stiamo parlando), non me lo spiego ma ti ascolto volentieri.

“ sono le conclusioni a cui sono arrivati gli ingegneri di DXO „ piano, le conclusioni degli ingegneri di DXO riguardano solo un aspetto della questione, ovvero il fatto che la maggiore densitá dei pixel compensa il rumore superiore di ciascuno di essi considerato singolarmente, questo é ragionevole, ma chi scrive sostiene qualcosa di più, ovvero che un sensore più denso a pari tecnologia presenta lo stesso rumore globale, ma vi sono altri aspetti in gioco. Se la dimensione dei pixel non influisse sul rapporto superficie sensibile/superficie geometrica le conclusioni di DXO potrebbero bastare a giustificare le conclusioni di chi scrive (relativamente al primo stadio di rumore, quello relativo alla distribuzione casuale della luce), ma vi sono dei limiti tecnologici.

“ La tecnologia ha diverse soluzioni ai problemi, come le microlenti.

Arriva più luce e il sensore cattura più fotoni non è così logico come pensi „ qui non ho ben capito cosa intendi, se aumento la superficie impegnata dai circuiti o dagli spazi non utilizzati tra i vari pixel, inserire le microlenti aiuta a ridurre questa perdita di superficie ma non avrai mai un recupero del 100% no? Diamo numeri a caso, se le microlenti permettessero di recuperare un 80% della superficie persa rimarrebbe comunque un 20% che non riesci a recuperare, e maggiore é la superficie totale da dover recuperare maggiore sará in termini assoluti questo 20%, quindi minore la superficie fotosensibile finale ovvero minore la luce registrata. Come scappi a questo problema?

“ Se non si scappasse chi comprerebbe mai una fotocamera oggi se non può almeno uguagliare una FF da 6mpx di 15 anni fa? „ perdonami però questa argomentazione mi sembra poco azzeccata ;) la tecnologia avanza, qui stiamo parlando di pari livello tecnologico. É tutto un compromesso, se l'obiettivo principale é massimizzare la qualitá d'immagine di un sensore non entra in gioco solo il rumore. Se aumento un po' la risoluzione, la perdita di qualitá che causo lato rumore é più o meno significativa dei benefici qualitativi dovuti alla maggiore risoluzione? Fino ad un certo punto l'incremento della risoluzione potrá essere giustificato (dipende molto da che fotocamera vuoi creare, se la vuoi veloce e con ottima pulizia/gamma dinamica ad alti iso aumentare la risoluzione crea più problemi dei benefici che apporta, se invece ti interessa maggiormente il dettaglio piuttosto che la velocitá o le capacitá in bassa luce raggiungerai un compromesso differente).

A questo proposito ho letto un articolo intervista molto interessante sulla progettazione del sensore della Sony a7rII, ad un certo punto si chiedeva ai responsabili del suo sviluppo come si fosse arrivati alla risoluzione di 42.4MP. La realizzazione retroilluminata e l'utilizzo di connessioni in rame permettevano un'efficienza superiore rispetto alla tecnologia del loro famosissimo sensore da 36MP; il loro interesse era realizzare un nuovo sensore che avesse oltre ad una risoluzione superiore anche una maggiore pulizia e una non inferiore gamma dinamica rispetto al precedente. A livello marketing il numero 50 funzionava molto, così tentarono nella direzione dei 50MP. Risultato? Introducendo un incremento così significativo della risoluzione, nonostante il superiore processo tecnologico il nuovo sensore da 50MP risultava avere più rumore e meno gamma dinamica del loro precedente pupillo da 36MP. Per rispettare gli obiettivi prefissati serviva calare la risoluzione, così il nuovo compromesso di 42MP trovò ragione nel risultare anche utile per la registrazione video in UHD con pixel binning 2x2. Questa spiegazione sottintende la correlazione tra risoluzione maggiore e aumento del rumore.

Sono abituato a non dare per oro colato quel che affermano i responsabili delle aziende produttrici (soprattutto quelle giapponesi), quindi nessuno dá per certo che questa storia rappresenti la realtá, al contempo non penso che un responsabile per un'azienda così rilevante fonderebbe una sua argomentazione su basi concettualmente sbagliate... Io non credo =)

(E Sony sa bene come costruire i sensori) |

|

Metti la tua pubblicità su JuzaPhoto (info) |

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.