|

|

inviato il 30 Luglio 2014 ore 12:43

Premessa: è una discussione tecnica; visionari e pluri ripetenti delle medie non si troverebbero a loro agio, si prega quindi di girare al largo.

Fare un sensore monocromatico è facile; basta togliere il filtro Bayer o x-Trans posto sopra. In realtà tutti i sensori sono monocromatici in senso stretto.

I sensori sono lineari; ciò significa che l'intensità del segnale in uscita è direttamente proporzionale all'integrale della radiazione incidente nel tempo.

Adesso vediamo i vantaggi di un sensore a cui è stato rimosso il filtro colore :

1) Non necessita di demosaicizzazione; non vi è alcun bisogno di passare da questa fase per ricostruire per interpolazione l'informazione sui canali colore.

Evitando la demosaicizzazione si possono evitare i difetti geometrici che l'algoritmo può introdurre, il più tipico è l'effetto "maze" ossia labirinto.

Qui è possibile vedere un confronto tra alcuni algoritmi di demosaicizzazione : www.pages.drexel.edu/~par24/rawhistogram/40D_Demosaicing/40D_Demosaici

2) Sul sensore arriva più radiazione, tipicamente la differenza è di uno stop; quindi il doppio della luce. Non è certo poco e il rapporto SNR migliora a tutte le sensibilità più alte. Inoltre sparisce il rumore di crominanza; rimane solo quello di luminanza.

3) Teoricamente il sensore è capace di distinguere nativamente più sfumature di grigio; il RAW consente 2^14 livelli = 16.384. Dopo la conversione in immagine si perdono parecchi livelli in effetti, ma ne rimangono comunque la gran parte.

Adesso vediamo quello che non sempre dicono e che non tutti sanno :

Togliere semplicemente il filtro colore sembra una ottima idea per ottenere immagini in bianco e nero, ma non è proprio così.

Un sensore senza nessun filtro colore registra semplicemente i dati di luminanza.

Se ragionassimo nel modo colore L*a*b* il sensore così configurato otterrebbe come risultato finale solo il canale L*.

L* è la chiarezza, che deriva dalla brillanza e a sua volta dalla luminanza.

Più è elevato il valore di L* più un oggetto ci appare luminoso, ma la percezione umana è molto complessa e non si basa solo su questo dato.

Infatti noi possiamo percepire due oggetti aventi la stessa coordinata L* come luminosità differente; questo è l'effetto Helmholtz-Kohlrausch.

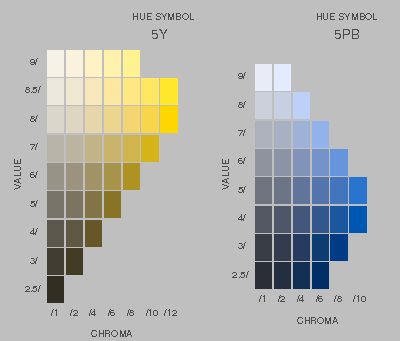

Vediamone un effetto pratico su un estratto del Munsell Book of Color :

Tutti i campioni di una fissata riga del Munsell Book of Color hanno, per costruzione, (a) lo stesso fattore di luminanza (che Munsell chiama valore, value) e (b) croma crescente (da sinistra a destra). Ma i campioni di croma elevata appaiono di maggiore chiarezza di quelli di bassa croma. Questa diversità di chiarezza può essere grande o piccola in funzione della tinta e del valore di Munsell. Quindi si può vedere di più in alcune tinte e in alcuni valori e di meno in altre.

Si nota facilmente che a fattore di luminanza costante, uno stimolo con croma maggiore appare di maggiore chiarezza.

Insomma la chiarezza di un colore non dipende strettamente e solo dal suo fattore di luminanza ma anche in una certa misura dalla sua croma. Se aumenta la croma aumenta anche la chiarezza.

Le tinte in cui questo effetto è più accentuato sono più o meno quelle dei blu, viola, magenta, rosso. Le tinte meno influenzate sono più o meno quelle del verde, giallo, arancio.

Se dovessimo convertire in BN una immagine a colori lo potremmo fare passando in L*a*b* e poi cassando le informazioni sul colore, ma il risultato cozzerebbe con la nostra percezione. Pur avendo perso le informazioni sul colore la nostra mente cerca di ristabilire il giusto rapporto nella chiarezza degli oggetti; non trovando quello che si aspetta otteniamo una sensazione alienante.

Quindi per fare una buona foto in BN ho bisogno delle informazioni sul colore; può apparire un controsenso, ma è l'unica strada.

Le vecchie pellicole infatti erano molto diverse da un sensore; ogni tipo di pellicola discriminava tra le varie lunghezze d'onda, essendo più sensibile, per esempio, al rosso e meno al blu.

Un sensore veramente monocromatico non riesce a fare distinzioni; allora come si può fare?

L'unica è mettere un filtro colore; la differenza è che sui sensori monocromatici per fotografia il filtro colore non è a griglia, ma uniforme e costante.

Questo filtro è più leggero e mono bloccante del filtro Bayer perché non ha necessità di separare i canali.

Si evince quindi che il sensore monocromatico per fotografia in realtà usa le informazioni sul colore; le usa prima di arrivare sui fotositi.

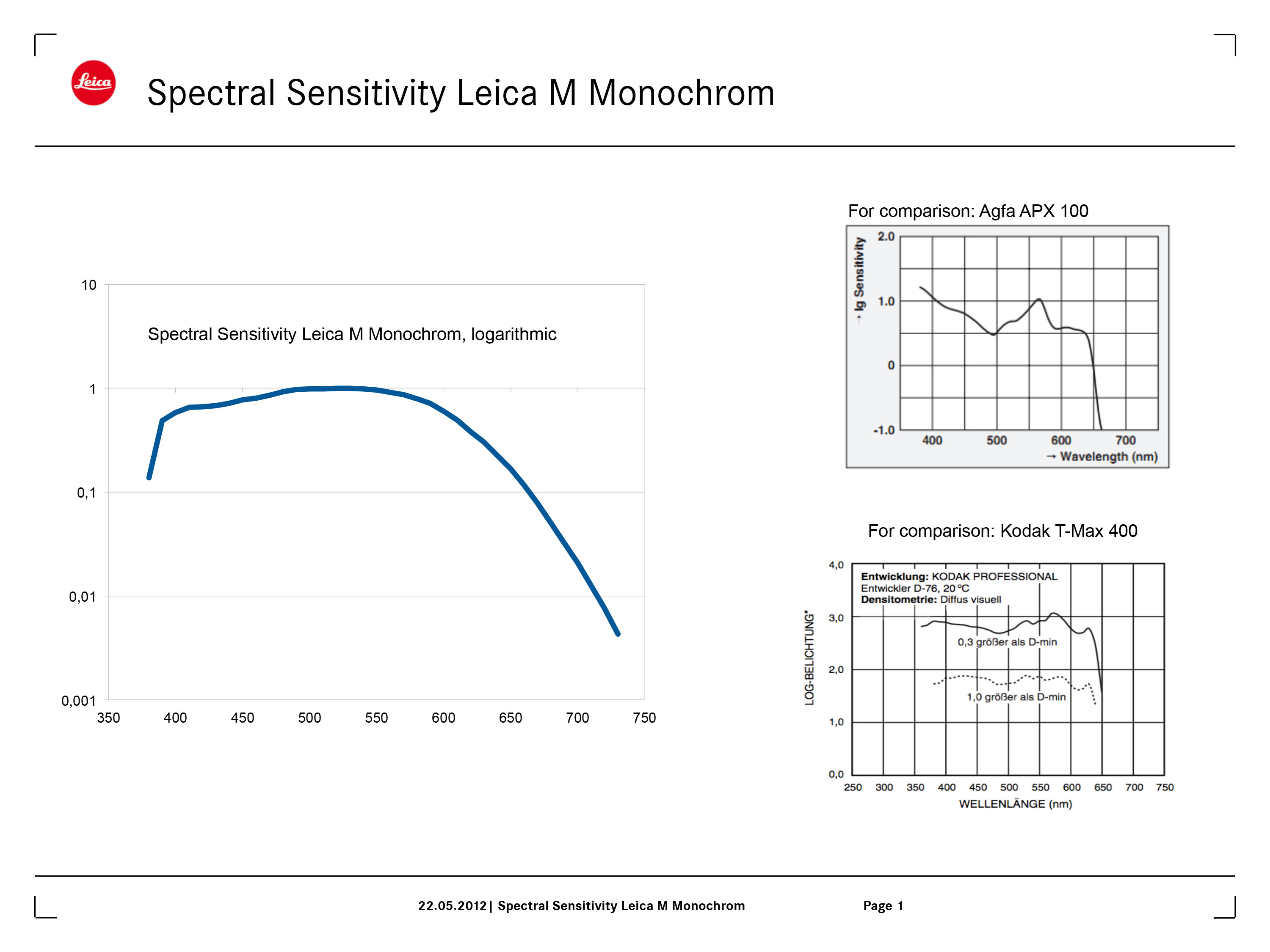

Possiamo vedere per esempio come Leica abbia progettato il filtro colore che c'è sulla Monochrom :

Come si può vedere il filtro colore taglia alcune frequenze, cercando di replicare il tipico flesso delle pellicole.

E' errato quindi affermare che questi sensori "usano tutta la luce", devono per forza schermare parte della radiazione proprio per avere un risultato piacevole alla vista umana.

Adesso continuiamo la nostra analisi e vediamo che succede quando i dati del sensore monocromatico vengono inseriti nel workflow :

Il RAW è a 14 o 16 bit, ma in entrambi i casi solo 14 bit sono usati per i dati.

Il RAW viene letto e decodificato, linearizzato; e poi i dati sono convertiti da device dipendent a scene referred. A questo punto si passa da RIMM al ProPhoto e abbiamo la nostra immagine aperta in Photoshop.

Qui iniziano i guai; per vedere la foto Photoshop deve inviarla a monitor eseguendo la compensazione. Il file si presume essere un Tiff a 16bit, ciò significa che usa 16 bit per ogni canale colore. Potenzialmente questo si traduce in 2^16 = 65.536 livelli di grigio. Photoshop però opera internamente a 15bit, quindi si va a 32.768 livelli di grigio. Sempre il doppio di quelli teoricamente presenti sul RAW.

Ma al monitor non arrivano 15bit per canale.... se il monitor è connesso con DisplayPort i bit sono 10, se è connesso con vga, dvi, hdmi i bit sono solo 8.

Nella migliore delle ipotesi quindi sul monitor vediamo 1024 livelli di grigio differenti, altrimenti solo 256.

Quindi vediamo in realtà poco di quello che potenzialmente offrono tali sensori; allo stesso modo una foto a colori convertita in BN incorre nello stesso problema.

Possiamo dire che la presentazione digitale delle immagini poco si adatta al BN.

Nella stampa le cose non vanno molto meglio; i driver comuni sono tutti a 8 bit.

I file di questi sensori trovano il loro giusto impiego solo nel caso si vada in stampa con plotter dedicati al BN e pilotati da un RIP a 16bit; ovviamente il tutto calibrato e profilato ad arte.

In conclusione possiamo dire che i sensori monocromatici pensati per la fotografia hanno vantaggi e svantaggi.

In questi sensori non possiamo cambiare il tipo di risposta; nessun miscelatore canale da usare con un SilverEfex o similari, e ovviamente non possiamo cambiare il rullino come una volta.

La loro resa è fissa e non possiamo intervenire in PP.

L'unica strada è usare i vecchi filtri colore sull'obiettivo; e ovviamente è una scelta che possiamo fare solo al momento dello scatto. Inoltre un ulteriore filtro colore diminuirà la luce incidente.

La cosa che invece non possiamo proprio fare è invertire la curva tipica del sensore; per esempio sulla Monochrome non posso esaltare le lunghezze d'onda tra 650 e 700 nanometri.

Possiamo lavorare solo in deprivazione; quindi se voglio che la lunghezza d'onda dominante sia, ad esempio, 650 nm devo deprimere tutto il resto.

Durante lo scatto, per dare una cosa simile, o si alzano i tempi o si sale di iso per compensare la parte di radiazione persa.

In ultima analisi direi che questi sensori sono sicuramente molto interessanti e validi, ma rimangono delle zone d'ombra.

I vantaggi che apportano non sono a costo zero. Se si è disposti a sopportare la perdita delle informazioni sul colore per avere i vantaggi sopra esposti allora macchine come la Monochrom saranno in grado di dare molte soddisfazioni.

Ma solo se si stampa, e si stampa veramente bene. Altrimenti tutti questi vantaggi "andranno perduti nel tempo

come lacrime nella pioggia". |

|

|

inviato il 30 Luglio 2014 ore 13:03

... È tempo di morire.

(meanwhile io mi tocco)

|

|

|

inviato il 30 Luglio 2014 ore 13:37

“ In ultima analisi direi che questi sensori sono sicuramente molto interessanti e validi, ma rimangono delle zone d'ombra.

I vantaggi che apportano non sono a costo zero. Se si è disposti a sopportare la perdita delle informazioni sul colore per avere i vantaggi sopra esposti allora macchine come la Monochrom saranno in grado di dare molte soddisfazioni. „

Sarei curioso di sapere che differenza c'è tra quello che stai scrivendo adesso e quello che ho scritto io per svariate pagine

Qualche post fa il sensore monocromatico era pari ad un bayer ed era puro marketing...

In quest'interessante disamina però continui a non considerare, tra i pro, altri due aspetti:

- la risoluzione è più alta, dato che un bayer ha una risoluzione effettiva inferiore alla conta teorica dei pixel... i file con la più alta risoluzione effettiva e nitidezza per pixel che ho visto sono di gran lunga quelli della monochrome e del fovenon.

- il filtro colore di cui parli è su tutto il sensore, quindi tutti i pixel lavorano sempre al meglio, mentre in un bayer quando un colore è predominante una gran parte dei pixel rimane, se non cieco, molto miope.

Poi è ovvio che nulla è gratis, quindi rinunciare all'informazione colore comporta anche delle rinunce. |

|

|

inviato il 30 Luglio 2014 ore 14:00

Raamiel

“ E' errato quindi affermare che questi sensori "usano tutta la luce", devono per forza schermare parte della radiazione proprio per avere un risultato piacevole alla vista umana.

„

Quello della Monochrom é filtrato così, immagino per comodità d'uso.

I Phase One P45 e IQ260 in versione Achromatic, che io sappia invece non sono filtrati (sono meno filtrati?) e vedono dall'UV all'IR. Presumo che poi si debbano usare filtri in fase di scatto.

Queste ad esempio le spec del KAF 39000 AA Kodak che montava il P45 Achromatic Plus, in confronto alla versione "a colori":

|

|

|

inviato il 30 Luglio 2014 ore 14:06

Non ho detto mai che il sensore monocromatico è puro marketing.

Ma è marketing far credere alla gente che il risultato sia inarrivabile per sensori Bayer.

Gli algoritmi di demosaicizzazione si sono evoluti molto; e possono dare risultati molto diversi in base alla loro complessità.

Nei software commerciali come Lightroom usi sempre un solo algoritmo, ovviamente proprietario; ma su un software come RawTerapee puoi vedere gli affetti di molti algoritmi.

Io non parlo per sentito dire; ho provato molti raw della monochrom e anche alcuni del IQ260 Achromatic. Facendo raffronti accurati con altri raw provenienti da M9 e IQ260 con Bayer; oltre che ovviamente i file della D800E e della A7r.

Francamente solo in casi molto rari e di dettagli molto fini ho riscontrano una superiorità, peraltro minima; sarebbe stato difficile indovinare senza una analisi accurata e paziente.

Poi certo in condizioni di luce sbilanciata fortemente il Bayer soffre; ma anche il Monochrom soffre se lo spettro della luce si sposta verso il rosso; meno di un Bayer, ma non è vero che lavora sempre al meglio.

Al solito le cose vanno viste nel dettaglio, altrimenti siamo superficiali.

I due punti più negativi rimangono la non libertà di poter reinterpretare in PP; un sensore con filtro colore (o un foveon) avendo l'informazione sul colore può simulare praticamente ogni pellicola a colori o in BN.

E l'altro punto negativo sono i limiti della tecnologia digitale per la presentazione dell'immagine.

La mia critica più grande non è verso la Monochrom o il concetto di sensore monocromatico, ma piuttosto verso chi professa l'evidente superiorità di questo mezzo su immagini jpg visualizzate a schermo.

La mia convinzione è che con l'attuale tecnologia, nel bene o nel male, si possa arrivare ad ottenere un BN di pari livello di quello di un sensore monocromatico, partendo da un sensore Bayer.

Ovviamente il tutto dipende dalla bravura a fare la giusta conversione; e questa è tecnica. Anche se a certi soggetti ciò non piace. |

|

|

inviato il 30 Luglio 2014 ore 14:13

Urca, è chiaro perfino ad un ripetente come me.

Ma siccome la mia missione in questo forum è quello di semplificare i concetti, autoquoto un mio intervento fatto nell'altro topic che sembra scherzoso ma di fondo pone una domanda.

"Prendiamo due pittori e mettiamoli davanti alla stessa chiesa, con due tele bianche e ad ognuno di loro diamo 256 pennelli di grigi differenti.

Diciamo loro di dipingere quella chiesa usando obbligatoriamente tutti e 256 pennelli, almeno una volta.

Finiti i quadri, pensate che siano uguali? Ovviamente no, la gente si accalca sui quadri e prova a giudicare quale preferisce.

Tra la folla si fa largo Raamiel che si piazza davanti ai due quadri, tira fuori un taccuino ed inizia a scrivere freneticamente, complessissime formule matematiche, dopodichè urla:

Fermi tutti!!!!! Questi due quadri sono identici!!!!

Il silenzio cala nella piazza, tutti sbigottiti lo guardano e gli chiedono: perchè???

E lui fiero risponde: perchè ho contato i grigi e sono uguali in entrambi i quadri!!! MrGreenMrGreenMrGreen

Ora, questo per dire che io potrei riprodurre un landscape utilizzando 30 tonalità di grigio per il cialo, 30 per il prato e poi per il pozzo sul prato ne utilizzo 256.

Quindi Raamiel con le sue formule vede che in quella foto ci sono 256 livelli di grigio.

Però lo stesso landscape lo posso riprodurre con 200 tonalità per il cielo, 200 tonalità per il prato e sempre le stesse 200 tonalità per il pozzo.

L'immagine sarà più ricca di tonalità, ma Raamiel con le sue formule conterà solo 200 tonalità di grigio invece di 256 e sentenzierà che è un B/N più povero.

Avete mai osservato una bella stampa in B/N su carta baritata da file analogico? Bene, tutti a sbavare, ma se andiamo a contare i livelli di grigio di quella stampa siamo poi così sicuri che siano più di 256??????

Morale, non è il numero del livello di grigi a determinare la foto, ma è il COME LI SI USA.

Probabilmente, il sistema di acquisizione della monochrom, riesce ad utilizzarne il più possibile per registrare ogni area dell'immagine che si trova davanti, noi vediamo solo una piccola porzione di 256 grigi di quello che è l'output finale ma, evidentemente, tutto il processo fatto a monte dalla monochrom, gli permette di inserirne una quantità maggiore ovunque."

Quindi, tornando a bomba, siamo poi così sicuri che su una rappresentazione web ad 8bit non si possano vedere differenze?

Io inizio a dubitarne, però chiedo a voi.

Raamiel scusa se ti ho citato nella storiella, era solo per capire se è poi così importante contare le scale di grigio in un B/N.

|

|

|

inviato il 30 Luglio 2014 ore 14:15

@Tiamat

Probabilmente è come dici; il sensore KAF 39000 vede molto bene anche nell'infrarosso e questa è una scelta che potrebbe migliorare la resa del BN.

Sull'ultravioletto l'estensione è minima perché di solito non sono graditi.

In fase di scatto sicuramente sono previsti dei filtri; del resto è un dorso progettato per foto in studio, dove hai tutto il tempo di gestire ogni aspetto e ripetere in caso di errore.

Il sensore KAF 39000 nello spettro di luce visibile è molto neutro, la sua efficienza è praticamente costante; presumo che usato non filtrato produca dei neri più brillanti per via della forte componente infrarossa.

Con il giusto filtro potrebbe interpretare diversi tipi di pellicola; ma questo è un procedimento che per forza di cose richiede uno studio di posa. |

|

|

inviato il 30 Luglio 2014 ore 14:21

Perchè l'affermazione sia corretta dovresti sostituire "di pari livello" con "di livello molto vicino"

Tra parentesi, mi stai dicendo che tu vedi la risoluzione del fovenon merril pari (o comunque simile) a quella di un aps-c da 15mpx? Davvero?

Dai un'occhiata a questo link blog.mingthein.com/2012/05/27/leica-m-monochrom-vs-d800e/

Fanno un confronto di risoluzione fra la monochrome (18mpx) e la d800e (36mpx) e concludono che i risultati sono all'incirca pari... ti immagini per dire che risoluzione avrebbe la d800 con un sensore monocromatico? |

|

|

inviato il 30 Luglio 2014 ore 14:23

Non devi scusarti con me; non ne hai motivo.

La storia del pittore fa ridere, ma non è realistica.

La macchina conta, elabora solo numeri; non interpreta. I sensori non possono decidere se riservare più scale di grigio su parte del soggetto e meno in altre aree.

Un dipinto passa da una interpretazione cosciente; il sensore è una macchina stupida. Non può far altro che registrare per come è progettato.

Se ho un file con informazione colore lo posso convertire in BN imitando la curva di risposta del sensore Monochrom; mi basta quel grafico.

Avevo già fatto questa prova con due foto; una della Monochrom e una della M9, foto praticamente identiche fatte con il medesimo obiettivo.

La foto Monochrom come uscita dalla macchina e la foto della M9 convertita da me, tenendo conto della risposta spettrale del sensore Monochrom. Il risultato era praticamente indistinguibile e i grigi erano distribuiti nel solito modo.

Mi domando in quanti avrebbero potuto riconoscere quale scatto era fatto dalla Monochrom. |

|

|

inviato il 30 Luglio 2014 ore 14:30

@Andreadefalco

quel test lo avevo già visto.... direi che non è molto attendibile; la lente usata è molto diversa.

La Leica monta quel mostro di 50/2 APO-Summicron-M ASPH, che risolve più di un Otus e la Nikon ha il 45/2.8 AI-P pancake.

Ora sono ragionevolmente certo che il Summicron APO dia un vantaggio non indifferente; del resto sono quasi 7000€ di lente, se non facesse differenza ci sarebbe da arrabbiarsi.

Anche i contrasti sono influenzati dal tipo di lente; direi che il test lascia il tempo che trova.... |

|

|

inviato il 30 Luglio 2014 ore 14:31

A mio parere la M Monochrom é una chicca filosofica, che strizza l'occhio alla storia Leica e cerca di essere il più minimalista possibile.

Poi se si va ad analizzare il file in sé ci sono alternative meno costose (o più costose) che fanno uguale o meglio, ma non é questo *a mio parere* il punto.

Con la Monochrom si ha un pacchetto di caratteristiche molto focalizzate, unico sul mercato, e questo lo apprezzo.

Non a caso, esistono dorsi BN o sono esistite DSLR BN, ma nessuno di questi prodotti ha fatto discutere e ha venduto quanto la Monochrom. |

|

|

inviato il 30 Luglio 2014 ore 14:31

“ La foto Monochrom come uscita dalla macchina e la foto della M9 convertita da me, tenendo conto della risposta spettrale del sensore Monochrom. Il risultato era praticamente indistinguibile e i grigi erano distribuiti nel solito modo.

„

Per curiosità, come hai fatto a convertirla tenendo conto della risposta spettrale del sensore Monochrom?

|

|

|

inviato il 30 Luglio 2014 ore 14:36

Questo è lo spettro di risposta della Monochrom :

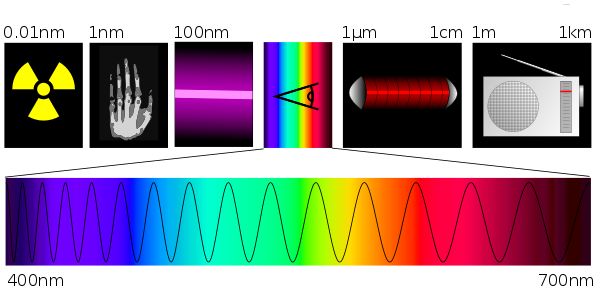

Ti dice a quali lunghezze d'onda è più o meno sensibile. E ti puoi regolare sapendo che lo spettro visibile è questo:

Usando il miscelatore canali applichi le dovute correzioni.

|

|

|

inviato il 30 Luglio 2014 ore 14:37

La M9 fa un ottimo bianconero. Non saprei dire se dello stesso livello della Monochrom. Sulla carta direi di no, ma non ho purtroppo scatti confrontabili.

Forse è ora di distinguere fra i concetti di "bianconero utilizzabile a scopi professionali ed artistici" e "bianconero allo stato dell'arte" , che sono due cose ben differenti.

(questo intervento non aggiunge molto valore al discorso, ma l'ho messo per poter trovare facilmente questa discussione fra le notifiche di Juza)   |

|

|

inviato il 30 Luglio 2014 ore 14:41

A quel punto dipende molto dalla PP a cui è sottoposto il file a colori.

Senza dimenticare che la resa della Monochrom è quella, ottima, ma è quella. Puoi modificare il contrasto in PP e altre cose, ma non fare i miracoli.

Se per qualche motivo si volesse un altro tipo di risposta; leggasi altro tipo di pellicola BN, che fai? Non è detto che il file della Monochrom sia sempre il migliore. |

Che cosa ne pensi di questo argomento?

Vuoi dire la tua? Per partecipare alla discussione iscriviti a JuzaPhoto, è semplice e gratuito!

Non solo: iscrivendoti potrai creare una tua pagina personale, pubblicare foto, ricevere commenti e sfruttare tutte le funzionalità di JuzaPhoto.

Con oltre 258000 iscritti, c'è spazio per tutti, dal principiante al professionista. |

Metti la tua pubblicità su JuzaPhoto (info) |

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.