|

|

inviato il 10 Maggio 2014 ore 12:53

Un titolo fantascientifico e misterioso per una allegra dissertazione intorno alla gamma dinamica nell'intera filiera fotografica; cercando nel frattempo di fare luce su alcune leggende metropolitane.

Prima di iniziare una raccomandazione: i fanboy e i vari pazzi da forum NON sono invitati alla discussione, si prega quindi di lasciare in pace; grazie.

La gamma dinamica in generale:

La gamma dinamica o intervallo dinamico è definito come: il rapporto tra il valore massimo possibile e quello minimo di una grandezza variabile.

In fotografia ci sono diverse gamme dinamiche che incontriamo durante il worflow...

La prima è la gamma dinamica della scena da riprendere. Vediamo di seguito come classificarla passando dalla fisica alla percezione:

radianza; grandezza fisica univoca misurata in watt su steradiante su metro quadrato (W?sr-1?m-2). Questa grandezza non dipende dalla percezione.

luminanza: (luminance); misurata in candele al metro quadro (cd/m^2). Questa grandezza è di natura psicofisica, quindi è il primo passo verso la nostra percezione. Essa è il risultato della radianza pesata spettralmente con la curva di efficienza del sistema visivo umano.

brillanza (brightness), grandezza psicologica che non ha unità di misura, solo un valore assoluto.

Meglio nota al pubblico nella versione standardizzata CIE 1976 e indicata con il simbolo L*

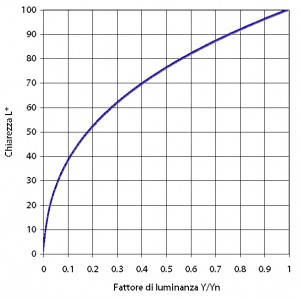

Questo è il grafico della corrispondenza tra luminanza e chiarezza:

La coordinata L* è usata anche nello spazio CIE Lab che vedremo dopo... |

|

|

inviato il 10 Maggio 2014 ore 12:53

Gamma dinamica del sensore:

Qui le cose si complicano; e curiosamente invece sono più semplici da un punto di vista scientifico...

La misura della gamma dinamica di un sensore è semplice e restituisce un valore certo e assoluto; di norma è fornita in stop, mentre quella del monitor è fornita sotto forma di rapporto.

Il punto inferiore è dato dalla minima lettura su almeno due dei canali RGB, altrettanto il massimo è fornito da una lettura che non porta a saturazione almeno due dei canali RGB. Questo relativo all'asse neutro dei grigi.

Il valore nominale che viene indicato è relativo alla sensibilità nativa del sensore; 100 ISO, talvolta 200 ISO, raramente valori diversi. Comunque sempre il valore di amplificazione base che il circuito A/D può usare.

Gamma dinamica dello schermo:

Similmente a un sensore anche i monitor hanno un rapporto dinamico nativo univoco; esso è dato dal rapporto tra il nero RGB (0,0,0) e bianco RGB (255,255,255) con luminosità standard. Questa gamma dinamica però è suscettibile di cambiamenti in quanto è necessario calibrare il monitor per portare il pannello in uno stato noto ed equilibrato.

La calibrazione quindi altera la cromaticità del pannello portando il punto di bianco a coincidere con un illuminante noto (tipicamente D65) e interessa anche la luminosità.

Nei pannelli LCD la luminosità è data dalla retroilluminazione, che rimane del valore impostato costantemente in ogni zona (fatta salva l'uniformità); più alziamo la luminosità massima più il valore di nero si discosta da zero perché per quanto opachi i cristalli dell'LCD non bloccano del tutto la luce.

La gamma dinamica ottenibile quindi è un compromesso, di solito si sceglie un valore di 120 - 140 candele al metro quadro per la luminosità massima e il nero risultante è la diretta conseguenza delle capacità del pannello.

Per esempio il mio Nec (un po attempato) è calibrato per 120 cd/m^2 e bianco D65, il nero risultante è 0,3 cd/m^2

Il rapporto di contrasto è 1:400 (che sia ora di cambiare monitor?)

Per sapere il contrasto in valori f stop basta normalizzare il valore nel logaritmo in base 2, log2(400)=8,64 (circa)

Quindi il mio monitor visualizza 8,64 stop di gamma dinamica. |

|

|

inviato il 10 Maggio 2014 ore 12:54

Adesso veniamo alla prima delle leggende metropolitane...

Che succede se il sensore ha una gamma dinamica superiore a quella del monitor?

La risposta che spesso circola e che la parte eccedente viene segata via e non la possiamo vedere. Errore....

La gamma dinamica come abbiamo detto è il rapporto tra il massimo e il minimo di un valore, un rapporto appunto, non un valore con unità di misura.

Che cosa succede in pratica? Il valore massimo possibile (bianco) registrato dal sensore viene tradotto nel valore massimo del monitor, altrettanto il valore minimo (nero) registrato dal sensore viene tradotto nel valore minimo del monitor.

A variare quindi è la distanza tra questi due punti e la gamma possibile di gradazioni che colmano questo spazio. Un monitor migliore ci consentirà di distanziare maggiormente massimo e minimo e avere un controllo più attento sulle gradazioni, tuttavia anche un monitor medio consentirà sempre la visione dell'intera gamma dinamica fornita dal sensore; che sarà in pratica compressa in quella del monitor.

Talvolta questo non è direttamente visibile quando apriamo un RAW; questo dipende dall'algoritmo con cui funziona il programma e la curva di contrasto che ci propone. Se dovesse essere necessario basta schiarire le ombre e recuperare le alte luci; i dati necessari sono stati comunque registrati dal sensore e sono presenti nel RAW. Una volta terminata questa operazione la foto resterà leggibile dalle luci alle ombre su ogni monitor calibrato e profilato.

Ma come è mai possibile una cosa del genere?? La risposta è nel motore ICC e lo spazio LAB e lo zio gamut ora ci spiegheranno il perché....

prendiamo a caso un gamut di un sensore, che chiamerò Paperino per non destare sospetti, e plottiamolo nello spazio LAB :

(ok ok... si vede il nome ma non mi andava di riuploadare il grafico)

Questo è il gamut del sensore Paperino secondo PhaseOne.

In seguito vedremo alcuni lati oscuri del gamut... ma per ora prendiamo il grafico per buono.

Le coordinate colorimetriche dei possibili colori catturabili sono contenute in quella nuvola e sono caratterizzate da tre valori : L* a* b*

a e b sono i colori opponenti e descrivono la componente cromatica, mentre L* è la brillanza; nel grafico L* è l'asse verticale centrale.

Come si nota facilmente quando si plotta un gamut relativo a un sensore esso ha sempre origine con L*=0 e termina con L*=100; indipendentemente dalla gamma dinamica di cui sono capaci, questo perché sono dispositivi per la cattura del colore (come anche gli scanner). E' quindi piuttosto ovvio che il gamut contempli il valore 100 (alte luci bruciate) e 0 (ombre perse).

Noi però non possiamo vedere questo gamut, in nessun modo. Prima di tutto perché la foto viene tradotta in un uno spazio colore di riferimento, come il ProPhoto (che ha un suo gamut), e poi perché gli unici gamut che possiamo vedere sono quelli delle periferiche che riproducono il colore (monitor, stampanti, ecc).

Cmq... facendola un po più semplice immaginiamo che il rapporto sia direttamente tra il gamut del sensore (in questo caso Paperino) e quello del monitor (in questo caso il mio povero NEC)

Questa è la situazione; per vedere la foto le coordinate colorimetriche devono essere tradotte tra i due spazi. L'operazione è chiamata compensazione a monitor e tutte le applicazioni che supportano le specifiche ICC ne sono capaci; come è piuttosto ovvio a essere interessata è tutta la terna di valori L* a* b*; quindi comprimere un gamut significa anche comprimere la gamma dinamica.

Il grafico non mette in evidenza bene le cose per quanto riguarda L* perché come ho già detto il gamut del sensore è sempre compreso tra 100 e 0 mentre quello del monitor e anch'esso originato in 0 e terminato in 100 perché è un profilo di tipo display.

Il risultato è che l'estensione di L* appare identica per i due dispositivi, mentre per il monitor dovrebbe essere compresa tra due valori diversi da 100 e 0 se dovessimo rappresentare i valori effettivamente raggiungibili dal pannello.

La compressione di L* avviene direttamente in hardware alla fine perché per esempio il valore L*=0 del sensore viene tradotto sempre L*=0 per il monitor, che andrà a visualizzare il suo massimo nero possibile (nel mio caso 0,3 cd/m^2), un valore diverso da L*=0 in senso assoluto. |

|

|

inviato il 10 Maggio 2014 ore 14:16

Un grazie di cuore Raamiel, ho letto tutto con estremo interesse e seguirò il resto della discussione. |

|

|

inviato il 10 Maggio 2014 ore 15:10

Seguo! |

|

|

inviato il 10 Maggio 2014 ore 16:11

Seguo anche io, spesso il buon Raamiel è autore di thread molto molto interessanti.

|

|

|

inviato il 10 Maggio 2014 ore 16:35

non credo si possa seguire senza avere almeno una base di conoscenze specifiche. ringrazio l'autore per la fiducia, seguo con interesse nella speranza di capire, ma finora, con scarsissimi risultati.

luca. |

|

|

inviato il 10 Maggio 2014 ore 17:07

Ora approfondiamo un attimo la gamma dinamica e il gamut dei sensori... scopriremo una realtà raccapricciante....

Prima di tutto vediamo cosa è un sensore alla sua base. Ogni sensore CMOS o CCD è un dispositivo analogico lineare; questo significa che ogni fotosito restituisce un segnale elettrico direttamente proporzionale all'intensità della sua esposizione; ossia: la funzione che regola la potenza del segnale in uscita a quella della potenza radiante raccolta è una retta.

Questo segnale viene raccolto, amplificato e digitalizzato dal circuito A/D. Ogni sensore è corredato da un elettronica che è tanto migliore quanti più sono i bit deputati a scandire questo valore analogico in un valore discreto digitale.

I corpi reflex 35mm oggi sono quasi tutti a 14bit, mentre dorsi digitali sono a 16bit; ciò significa che nelle nostre reflex ci sono 2^14=16384 livelli possibili.

Qui inizia una delle leggende metropolitane più insidiose..... perché in buona parte è vera.

La diretta conseguenza di quantizzare un segnale lineare è che al dimezzarsi del segnale si hanno a disposizione la metà dei livelli; bene... prendiamo il sensore Paperino che abbiamo visto prima. DxO mark ci dice con ragionevole certezza che la gamma dinamica di questo sensore è di 14,3 stop; proviamo a fare due conti:

1 zona 8192 livelli

2 zona 4096 livelli

3 zona 2048 livelli

4 zona 1024 livelli

5 zona 512 livelli

6 zona 256 livelli

7 zona 128 livelli

8 zona 64 livelli

9 zona 32 livelli

10 zona 16 livelli

11 zona 8 livelli

12 zona 4 livelli

13 zona 2 livelli

14 zona 1 livelli

mmmm.... qualcosa non torna, a occhio le zone inferiori hanno troppi pochi livelli, oppure quelle superiori ne hanno troppi? La leggenda metropolitana racconta la storia fino a questo punto e conclude dicendo che i 14 stop sono balle.

Ma invece mancano ancora tanti ingredienti per cucinare la realtà...

Intanto vediamo la differenza tra il sensore e la percezione umana:

Abbiamo detto che il sensore di per se è lineare, ed è così; il nostro occhio invece è molto più furbo e non è lineare, è relativo.

Noi percepiamo la differenza di luminosità secondo la curva di L* che ha un andamento caratterizzato da quello che chiamiamo gamma.

Ora vediamo la correzione gamma che si usa per i monitor :

La linea retta centrale è la risposta lineare, la gamma 2.2 è tipica di un pannello CRT ed è stata replicata sui monitr LCD per mantenere la compatibilità; la gamma 1/2.2 è la correzione. Perché è necessaria? vediamo in figura :

Ecco... nel primo caso la telecamera (o fotocamera) invia a video una risposta lineare, ma il monitor da una risposta non lineare in gamma 2.2; come risultato l'immagine è distorta.

Nel secondo caso il segnale inviato è corretto con un valore gamma negativo rispetto al gamma del video; il risultato è una curva neutra; il monitor ribilancia la distorsione che abbiamo aggiunto.

Un valore gamma gamma<1 è chiamato di solito un gamma codificante, e il procedimento di codifica con la suddetta legge di potenza ad esponente minore di 1 è chiamato compressione gamma; viceversa, un valore gamma gamma>1 è chiamato gamma decodificante e l'applicazione di tale non linearità mediante semplice legge di potenza espansiva, cioè con esponente maggiore di 1, è chiamata espansione gamma.

Tutto questo ci serviva per arrivare al punto.... come si nota il segnale in codifica gamma espande i livelli delle ombre e comprime i livelli delle luci.

E una delle fasi di codifica di un immagine partendo dal RAW è la linearizzazione ..... Inizia a essere più chiaro adesso?

Infatti i dati del RAW NON sono lineari; il sensore è lineare, ma prima di passare alla codifica A/D il segnale viene codificato con una gamma negativa.

Quindi la storiella raccontata sopra è parecchio incompleta... e non è tutto. Continuiamo cercando di capire meglio cosa comporta la compressione della gamma.

Abbiamo visto prima che se la codifica A/D avvenisse su dati lineari le prime zone più luminose avrebbero tanti livelli e le ombre molto pochi, ma quale valore è giusto? 1000? 100? 200?

Per capire il tutto dobbiamo comprendere la visione umana :

L'occhio umano è sensibile alle relative differenze di luminanza. Ecco perché pensiamo l'esposizione in termini di zone o f-stop, dove cambia l'esposizione di un f-stop o zona significa dimezzare o raddoppiare la luce. La più piccola differenza di luminanza che l'occhio può distinguere in piena luce (Delta L) è espresso dalla legge di Weber-Fechner:

Delta L / L = 0,01

Questa è una differenza relativa di 1%, pari a 1/70 di una zona di esposizione.

Quindi il valore giusto sono 70 livelli? Nelle zone più luminose sì, mentre nelle ombre la percezione umana cala e distingue progressivamente meno livelli.

Per curiosità... sapete quanti livelli sono codificati nel primo stop di un file 8bit in gamma 2.2? 69  , mentre se il file è a 16bit (cioè quello che usiamo internamente per le modifiche alla foto) ha 17.712 livelli. , mentre se il file è a 16bit (cioè quello che usiamo internamente per le modifiche alla foto) ha 17.712 livelli.

La codifica gamma operata dal circuito del sensore non è nota, ma viene invertita al momento della linearizzazione dei dati dal RAW converter. Quale essa sia è sufficiente a dare abbastanza livelli di discernimento per concretizzare i 14 stop di gamma dinamica. |

|

|

inviato il 10 Maggio 2014 ore 17:31

Fine della storia? eh.. no no... mancano ancora due attori di estremo peso nella faccenda; fino a qui siamo ancora nel mondo della marmotta che fa la cioccolata, ma come sappiamo in verità le cose non sono così dolci.

Ecco che entrano in scena i simpatici SINAD ed ENOB, cosa sono? la dura realtà dei sistemi reali...

Il SINAD (dall'inglese Signal-to-noise and distortion ratio) è un parametro delle telecomunicazioni che rappresenta la qualità del segnale uscente da un dispositivo, ed è definito come :

dove P rappresenta la potenza media delle componenti di segnale, rumore e distorsione. Il SINAD è solitamente espresso in dB e viene usato per dare una valutazione quantitativa della sensibilità del ricevitore. A differenza del rapporto segnale/rumore, questo parametro assumerà sempre un valore maggiore di uno (ossia un valore sempre positivo se valutato in dB).

Di solito il SINAD è correlato alle telecomunicazioni, ma è presente anche qui; soprattutto perché ci porta ad ENOD:

L'ENOB (dall'inglese Effective Number of Bits, ovvero Numero di bit effettivi) è un parametro usato per misurare la qualità di un segnale digitalizzato. Infatti di solito il circuito A/D è identificato dal suo numero di bit nativi (14 per noi), ma mai dal suo ENOD. Quindi i produttori dichiarano solo la risoluzione nominale del circuito A/D, mentre dovrebbero dichiarare l'ENOD per dirci quanto è buono il circuito.

La formula di ENOD è semplice :

Quindi ci sono A/D e A/D, mica son tutti uguali.

I conti non li possiamo fare perché tali dati non sono pubblici, ma possiamo vedere un caso reale per farci una idea.

Prendiamo il sensore Paperino e mettiamolo a confronto con il sensore Pippo:

Fred Miranda ci viene in aiuto offrendoci un confronto ben fatto...

Prima foto, la scena riprese con la medesima esposizione :

Primo crop delle ombre aperte per il sensore Pippo :

Primo crop delle ombre aperte per il sensore Paperino :

Secondo crop delle ombre aperte per il sensore Pippo :

Secondo crop delle ombre aperte per il sensore Paperino :

Entrambi i sensori codificano con A/D a 14 bit. Che è successo al povero Pippo? Il cattivo SINAD e l'orrido ENOB hanno disintegrato la qualità del segnale. |

|

|

inviato il 10 Maggio 2014 ore 18:31

Una considerazione ulteriore da fare....

Lo spazio LAB, questo mondo imperfetto:

Lo spazio LAB è considerato da molti, e a buon ragione, lo spazio ideale. Infatti esso è usato come spazio colore per gestire le trasformazioni tra vari spazi colore di riferimento; ad esempio Photoshop usa LAB per gestire la transizione da Pro[negozio 24] AdobeRGB e qualsiasi altra trasformazione tra altri spazi colore.

Lo spazio LAB usa la chiarezza psicometria L* CIE 1976. La chiarezza è un attributo della sensazione visiva dovuta a corpi superficiali posti in relazione al bianco di riferimento (Xn, Yn = 100, Zn) e rappresenta la frazione di luce da questi riflessa diffusamente:

Il sistema CIELAB nasce considerando separatamente la chiarezza L* e le coordinate cromatiche (a*, b*), le quali sono prodotte da trasformazioni non lineari.

Lo spazio CIELAB non è più uno spazio vettoriale, come è lo spazio del tristimolo, ma è normato. In questo spazio la differenza percepita tra i colori è rappresentata dalla loro distanza euclidea.

Quindi L* nello spazio LAB è basata solo sul fattore di luminanza, ma mica è tanto precisa sta cosa....

Manca la considerazione dell'effetto Helmholtz-Kohlrausch (brutta bestia già dal nome).

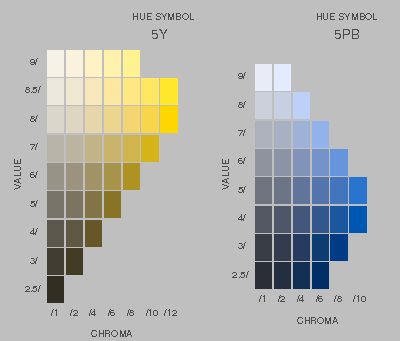

Vediamone un effetto pratico su un estratto del Munsell Book of Color :

Tutti i campioni di una fissata riga del Munsell Book of Color hanno, per costruzione, (a) lo stesso fattore di luminanza (che Munsell chiama valore, value) e (b) croma crescente (da sinistra a destra). Ma i campioni di croma elevata appaiono di maggiore chiarezza di quelli di bassa croma. Questa diversità di chiarezza può essere grande o piccola in funzione della tinta e del valore di Munsell. Quindi si può vedere di più in alcune tinte e in alcuni valori e di meno in altre.

Si nota facilmente che a fattore di luminanza costante, uno stimolo con croma maggiore appare di maggiore chiarezza.

Insomma la chiarezza di un colore non dipende strettamente e solo dal suo fattore di luminanza ma anche in una certa misura dalla sua croma. Se aumenta la croma aumenta anche la chiarezza.

Le tinte in cui questo effetto è più accentuato sono più o meno quelle dei blu, viola, magenta, rosso. Le tinte meno influenzate sono più o meno quelle del verde, giallo, arancio.

Ne consegue che lo spazio LAB, per quanto sofisticato, sia una approssimazione ancora piuttosto lontana del nostro apparato sensoriale visivo.

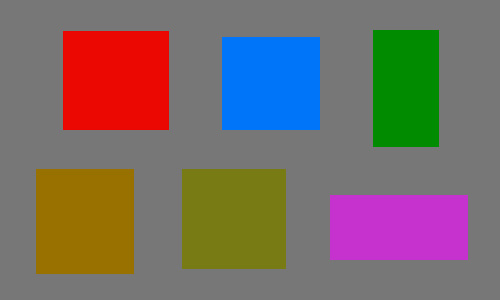

Ciò ha alcune conseguenze, una delle quali è che se creiamo in Photoshop diverse aree colorate tutte con la stessa L, dovrebbero apparire tutte ugualmente chiare (perché L indica appunto la chiarezza), ma in realtà non è così. Nell'immagine qui sotto tutti i rettangoli hanno L = 50, compreso lo sfondo, quindi hanno tutti la stessa chiarezza L. Ma in realtà alcuni appaiono più chiari e altri meno chiari.

|

|

|

inviato il 10 Maggio 2014 ore 21:38

Ma più che un imperfezione di Lab mi sembra imputabile a un imperfezione del nostro sistema di visione il fatto che alcuni colori sembrano più chiari di altri. |

|

|

inviato il 10 Maggio 2014 ore 21:50

Eh no, lab nasce per emulare il nostro sistema percettivo, mica viceversa.

E' il modello di lab che difetta nel descrivere la visione umana. |

|

|

inviato il 10 Maggio 2014 ore 21:59

@Scattipercaso

Sulle alte luci Paperino si comporta come Pippa, nei limiti delle differenze che ogni tecnologia comporta.

Sulle alte luci fa più differenza l'esposimetro, che ovviamente non deve bruciarle; altrimenti addio.

Le alte luci comunque sono la parte più facile per ogni sensore perché è lì che il rapporto segnale rumore è più efficiente, inoltre il circuito A/D campiona anche più finemente.

Nella prima metà destra dell'istogramma Paperino e Pippa sono praticamente identici, sfido a indovinare quale sensore sia guardando una foto dopo la PP se nella foto non sono presenti delle ombre con dettagli. |

Che cosa ne pensi di questo argomento?

Vuoi dire la tua? Per partecipare alla discussione iscriviti a JuzaPhoto, è semplice e gratuito!

Non solo: iscrivendoti potrai creare una tua pagina personale, pubblicare foto, ricevere commenti e sfruttare tutte le funzionalità di JuzaPhoto.

Con oltre 258000 iscritti, c'è spazio per tutti, dal principiante al professionista. |

Metti la tua pubblicità su JuzaPhoto (info) |

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.