| inviato il 22 Marzo 2020 ore 11:59

Grazie Valgrassi per la risposta,

hai confermato le mie assunzioni di partenza ed i dubbi sulle unità di misura (non ero sicuro che cy/mm fosse sempre ed universalmente equivalente a lp/mm).

Adesso posso farti domande con risvolti pratici.

Ho sempre letto in rete che la frequenza di Nyquist fosse la massima risoluzione teorica di un sensore; per avere quella effettiva, per tenere conto dello schema Bayer, bisogna dividere per un fattore che mediamente viene indicato fra 1.3 ed 1.5.

Dall'applicazione della formula invece risulta che alla frequenza di Nyquist si ha MTF64, valore molto superiore a quello che generalmente si considera come limite di risolvenza, cioè MTF10 o MTF20 al massimo.

E d'altra parte se le linee della mira ed i pixel cadono a cavallo si ha MTF0 alla frequenza di Nyquist e si dovrebbe avere MTF100 se coincidono perfettamente.

Ha quindi senso utilizzare la formula MTFsensore, e di conseguenza quella della MTFtotale, per frequenze prossime a quella di Nyquist?

La nitidezza non è una grandezza misurabile ma percepita, sono state fatte prove fatte su individui a cui venivano fatte vedere delle immagini e sembra che sia legata soprattutto ad un buon contrasto su frequenze alte ma non ancora vicine al limite del dettaglio distinguibile.

|

user175879 | inviato il 22 Marzo 2020 ore 12:03

“ Il rumore, che limita l'estensione verso il basso, se ingrandisci di più (cosa che occorre fare con i sensori più piccoli per avere la stessa dimensione di stampa) si vede di più e diventa più importante rispetto al segnale. „

|

| inviato il 22 Marzo 2020 ore 12:18

“ Sulla diffrazione, che affliggerebbe le bigmpx più delle altre, anche in questo caso, non è vero ciò vero ma quel che sembra, ovvero che se ragioniamo al 100% è vero, ma se normalizziamo l'output, accade questo: „

Certamente che funziona così, e questo vale per diffrazione, micromosso, obiettivo poco performante, difetti di messa a fuoco; se si normalizza non fai di sicuro peggio, migliori anche se di poco.

Se le condizioni sono ideali invece fai parecchio meglio.

Ed anche se un file di una 24MP a 300dpi ti copre esattamente le misura di stampa che vuoi fare, da una 48MP ridimensionata alle dimensioni di una 24MP ottieni un file di partenza migliore.

Bisogna sempre ricordare che 2/3 dei dati dei pixel di un'immagine sono calcolati e non misurati, si possono migliorare le cose con ricampionamento verso il basso oppure con la fusione di più immagini con piccolissimi scostamenti.

Chiaramente si possono ottenere bellissime stampe con il file originario, ma più MP non possono fare danni a parità di modalità di fruizione dell'immagine.

Fare delle misure con un metro senza tacche dei millimetri può essere più che sufficiente per molte cose, ma se ci sono anche i millimetri non è che le misure sono più imprecise.

|

| inviato il 22 Marzo 2020 ore 12:19

Ma poi dico, per provare, ci vuole molto? Ognuno che ha una FF ha in casa anche una potenziale "aps-c", basta ritagliare la parte centrale.

Si monta uno zoom, si fanno due foto su una scena molto contrastata, adattando la focale in modo da inquadrare il medesimo angolo di campo, si espone al limite delle luci e poi si aprono le ombre più scure, in ultimo si portano le foto alla stessa risoluzione (cosa che fanno in molte delle prove di comparazione della GD, la più famosa è quella mostrata da DxOMark nel rank delle fotocamere), e si vede cosa è uscito.

Dai, è semplice...ma a postare degli esempi VERI e non solo chiacchiere, siamo sempre i soliti quattro gatti; tanti, chiedono atti di fede. |

| inviato il 22 Marzo 2020 ore 12:30

Senza filtro aa... |

| inviato il 22 Marzo 2020 ore 13:55

“ La mia impressione è che tu confondi la gamma dinamica con il numero di passaggi tonali che ci sono tra il punto più scuro e quello più chiaro di un'immagine. In realtà la gamma dinamica è un rapporto che tiene conto solo dei valori minimo e massimo possibili e non delle sfumature intermedie, „

Il problema è proprio che la gamma dinamica NON indica la differenza tra il punto più scuro e quello più chiaro, ma indica quanti livelli di luminosità diversi sono riproducibili da ciascun pixel.

L'ho scritto qualche pagina fa il calcolo, per avere la gamma dinamica devi dividere il numero massimo di elettroni raccolti nel pixel (la Full Well Capacity, FWC) per il rumore di lettura del pixel (read noise, ovvero quanto è preciso il convertitore a leggere la carica di ciascun pixel).

Purtroppo i costruttori di reflex normali non divulgano quei dati (e imho è un peccato dato che se fossero più trasparenti si eviterebbe un sacco di confusione), ma si possono trovare per camere più specializzate tipo quelle per astrofotografia.

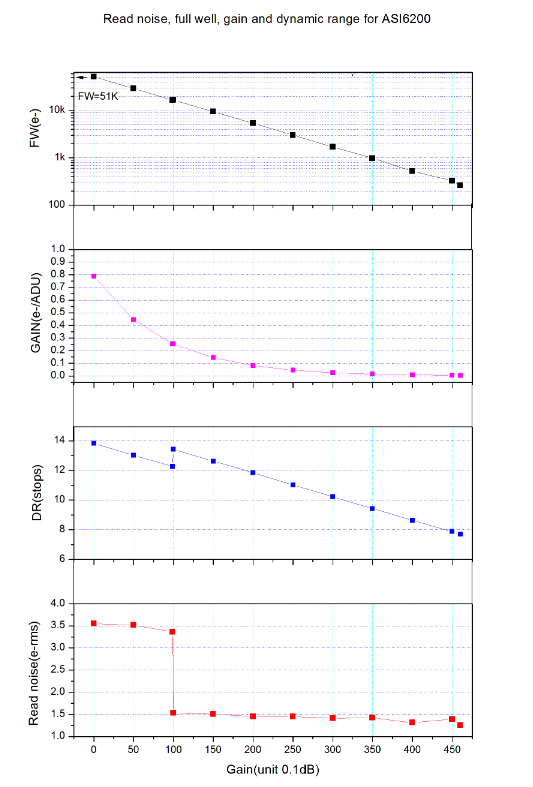

Questa ad esempio monta lo stesso sensore della A7r4 astronomy-imaging-camera.com/product/asi6200mc-pro-color

Ciascun pixel raccoglie circa 51.000 elettroni al gain minimo, il read noise sempre a gain minimo (cioè quelli che in fotografia normale sarebbero i bassi ISO) è di 3,5e.

51.000/3,5= 14571 sfumature diverse, tradotte in stop facendo il logaritmo di 14571 in base 2 = 13,83 STOP.

P.S. dal sito si nota che la camera monta un convertitore a 16 bit, il che può sembrare superfluo dato che ne basterebbero 14 (come sulla A7IV classica) per descrivere tutti i 13,8 stop di sfumature, ma con 16 si riduce l'errore di quantizzazione dovuto alla conversione in digitale. In realtà mi pare di aver letto che anche la A7IV usi un convertitore a 16bit per poi fare l'output a 14, ma non divaghiamo altrimenti non se ne esce più

|

| inviato il 22 Marzo 2020 ore 13:58

“ In realtà mi pare di aver letto che anche la A7IV usi un convertitore a 16bit per poi fare l'output a 14 „

Esatto... |

| inviato il 22 Marzo 2020 ore 14:43

La a7 iv? È già uscita? |

user175879 | inviato il 22 Marzo 2020 ore 14:45

“ Il problema è proprio che la gamma dinamica NON indica la differenza tra il punto più scuro e quello più chiaro, ma indica quanti livelli di luminosità diversi sono riproducibili da ciascun pixel. „

Ho sempre sospettato che stavamo parlando di cose diverse. Ne prendo atto, mi risulta comunque difficile pensare che due fotositi di uguali caratteristiche possano generare segnali diversi solo perché inseriti in sensori più o meno estesi. Tutt'al più un fotosito di un sensore più piccolo è 'costretto' a mediare i valori di una sezione di scena più estesa. Il che paradossalmente in casi limite potrebbe anche voler dire maggior compressione e minor clippaggio . |

| inviato il 22 Marzo 2020 ore 15:27

Sì ma la sostanza resta quello che ti ho esposto io, il crop aps-c di un sensore ff a parità di scena inquadrata (quindi con DIFFERENTE focale) e dimensioni di output ha meno lavorabilità, ossia più rumore sulle ombre, del frame intero. |

| inviato il 22 Marzo 2020 ore 15:39

“ La a7 iv? È già uscita? „

Scappata una r

“ Ne prendo atto, mi risulta comunque difficile pensare che due fotositi di uguali caratteristiche possano generare segnali diversi solo perché inseriti in sensori più o meno estesi „

Ma infatti NON generano segnali diversi, motivo per cui il crop APS-C da fullframe è identico ad una vera APS-C.

La differenza è che quando si sfrutta l'intero sensore e poi si ricampiona a risoluzioni più basse il segnale si somma linearmente mentre il rumore si somma sotto radice dato che è casuale, quindi il rapporto segnale rumore aumenta.

I pixel però sono sempre quelli, per la A7rIV avrai sempre 13,8 Ev di gamma dinamica "vera" su ciascun pixel, quei 14+ stop che vedi in giro sono "virtuali".

Ne prendo atto, mi risulta comunque difficile pensare che due fotositi di uguali caratteristiche possano generare segnali diversi solo perché inseriti in sensori più o meno estesi: Sensore 1 da 10mpx e sensore 2 da 40mpx grande il quadruplo, pixel identici.

Entrambi hanno un read noise di 2e- per pixel e 20.000e- di FWC per pixel. La GD REALE a livello del singolo pixel è 13,28 STOP.

Se però si riduce l'immagine del Sensore 2 da 40 a 10mpx, ciascun pixel è composto da 4 pixel, quindi la FWC totale diventa 80.000 ma il rumore di lettura diventa SQRT(2²*4)=4. La gamma dinamica del "superpixel" è quindi 80.000/4=20.000, tradotto 14.28 Stop

Certo se si intende erroneamente la GD come differenza tra la parte più luminosa e quella più scura la cosa risulta strana, perché qualunque sia la dimensione del sensore se clippi... clippi! |

| inviato il 22 Marzo 2020 ore 15:56

Bubu evidentemente non tutti riescono a capire la differenza che c'è a livello di pixel, ed a pari output... |

user175879 | inviato il 22 Marzo 2020 ore 16:29

Bene, almeno siamo tutti d'accordo che non ho capito. E' comunque un primo passo  poi cercherò di approfondire la questione su cosa intende un fotografo quando parla di gamma dinamica. Grazie. poi cercherò di approfondire la questione su cosa intende un fotografo quando parla di gamma dinamica. Grazie. |

| inviato il 22 Marzo 2020 ore 18:53

Ma inizialmente non si parlava di nitidezza e risoluzione ? |

Che cosa ne pensi di questo argomento?Vuoi dire la tua? Per partecipare alla discussione iscriviti a JuzaPhoto, è semplice e gratuito!

Non solo: iscrivendoti potrai creare una tua pagina personale, pubblicare foto, ricevere commenti e sfruttare tutte le funzionalità di JuzaPhoto. Con oltre 257000 iscritti, c'è spazio per tutti, dal principiante al professionista. |

Metti la tua pubblicità su JuzaPhoto (info) |

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.

JuzaPhoto contiene link affiliati Amazon ed Ebay e riceve una commissione in caso di acquisto attraverso link affiliati.